DCLM-7B是苹果与合作伙伴一起推出的开源小型语言模型,全部开源,包括权重、训练代码和数据集。DCLM-7B性能优异,接近大型模型,采用decoder-only架构,上下文长度2048。DCLM-7B在多个基准任务上性能出色,支持商业使用。

DCLM-7B的主要特性

DCLM-7B的主要特性

- 模型规格:DCLM-7B 基础模型是在 2.5 万亿个词库上训练出来的,主要使用英语数据,上下文窗口为 2048。

- 训练数据集:结合来自 DCLM-BASELINE、StarCoder 和 ProofPile2 的数据集。

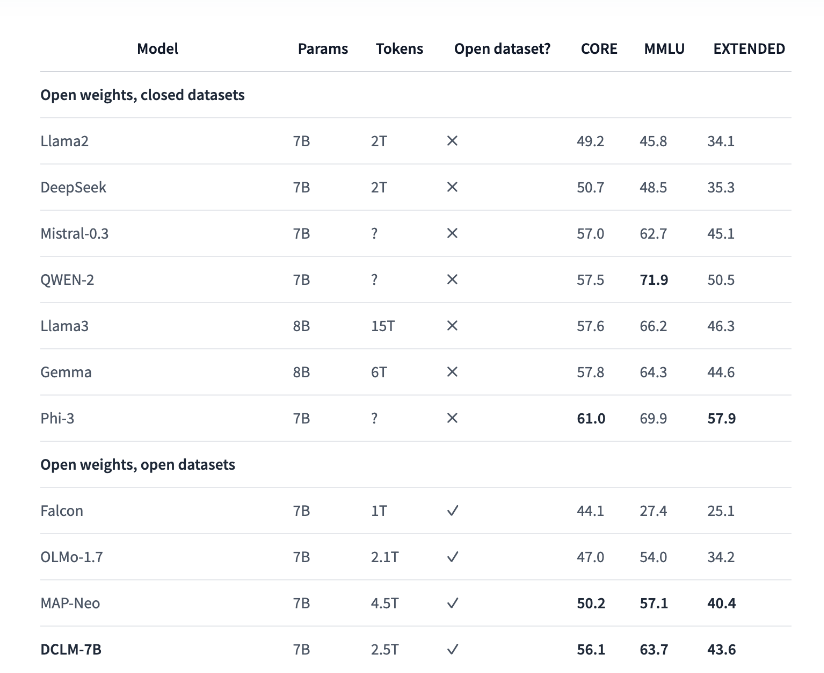

- 性能表现:该模型的 MMLU 得分为 0.6372,性能高于 Mistral,但低于 Llama3。

- 训练框架:使用 PyTorch 和 OpenLM 框架开发。

- 许可证:根据开放许可证发布,特别是苹果示例代码许可证。

- 可用性:目前,HuggingFace上已经发布了全部模型权重。

DCLM-7B的性能评测

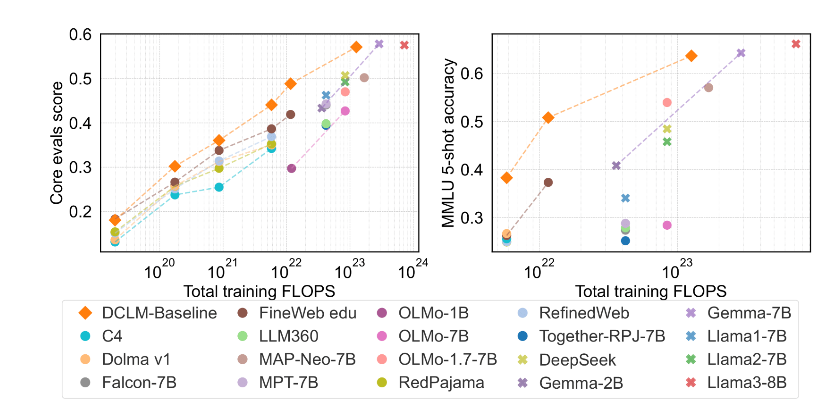

DCLM-7B在MMLU基准上5-shot准确率达64%,可与Mistral-7B-v0.3(63%)和Llama3-8B(66%)相媲美;并且在53个自然语言理解任务上的平均表现也可与Llama 3 8B相媲美,而所需计算量仅为后者的1/6。

与其他同等大小模型相比,DCLM-7B的MMLU得分超越Mistral-7B,接近Llama 3 8B。

与其他同等大小模型相比,DCLM-7B的MMLU得分超越Mistral-7B,接近Llama 3 8B。

如何使用DCLM-7B?

如何使用DCLM-7B?

目前,HuggingFace上已经发布了全部模型权重,其中的模型卡已经基本涵盖了关键信息。

- 模型地址:https://huggingface.co/apple/DCLM-7B

- GitHub:https://github.com/mlfoundations/dclm

- 数据集:https://huggingface.co/datasets/mlfoundations/dclm-baseline-1.0

- 论文:https://arxiv.org/pdf/2406.11794

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END