SmolLM是由 Huggingface 最新发布的一系列最先进的小型语言模型,有三种规格:1.35亿、3.6亿和17亿个参数。这些模型建立在 Cosmo-Corpus 上,Cosmo-Corpus 是一个精心策划的高质量训练数据集。Cosmo-Corpus 包括 Cosmopedia v2(由 Mixtral 生成的 280 亿个合成教科书和故事词块)、Python-Edu(由 The Stack 提供的 40 亿个 Python 教育样本词块)和 FineWeb-Edu(由 FineWeb 提供的 2200 亿个重复教育网络样本词块)。

SmolLM模型适合需要在本地设备上运行语言模型的开发者和研究人员。它们特别适合那些需要在资源受限的环境中进行高效推理的应用场景,如智能手机、笔记本电脑等。

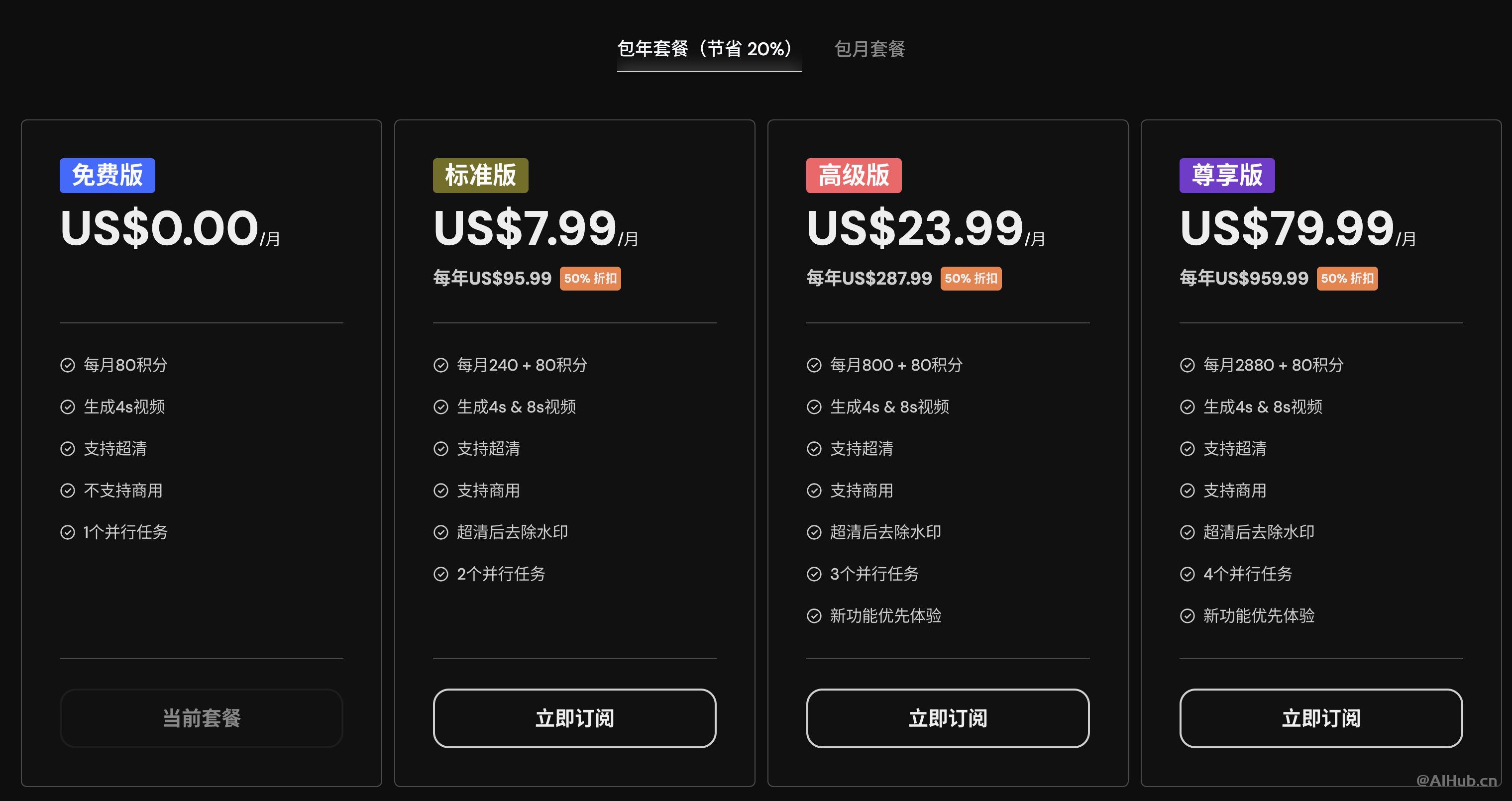

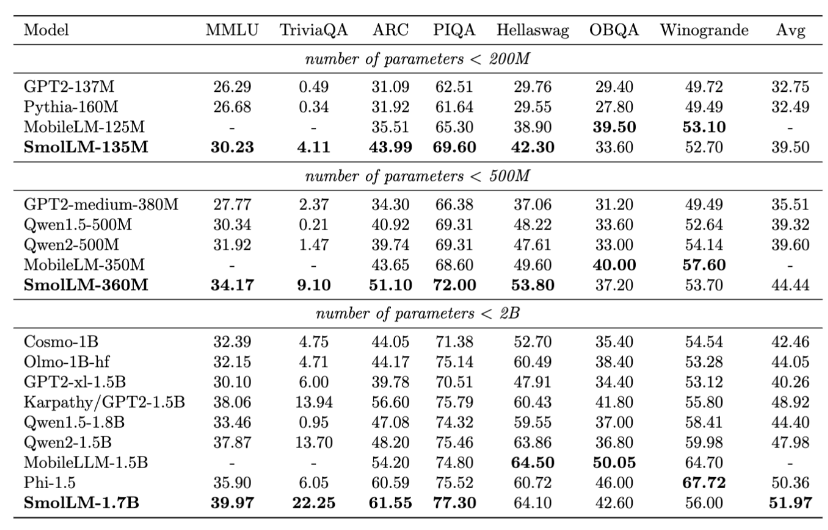

SmolLM的测试结果

SmolLM的测试结果

Hugging Face 团队将开发出的 SmolLM 模型与相同参数量的其他模型进行了基准测试,其中 SmolLM-135M 在多项测试中超越了小于 2 亿参数的其他模型;而 SmolLM-360M 的测试成绩优于所有小于 5 亿参数以下的模型,不过某些项目逊于 Meta 刚刚公布的 MobileLLM-350M;SmolLM-1.7B 模型则超越了所有参数量小于 20 亿参数的模型,包括微软 Phi-1.5、MobileLLM-1.5B 及 Qwen2。

在不同的推理和常识基准上评估 SmolLM 模型

在不同的推理和常识基准上评估 SmolLM 模型

如何使用SmolLM?

- SmolLM项目地址:https://huggingface.co/blog/smollm

- SmolLM模型合集:https://huggingface.co/collections/HuggingFaceTB/smollm-6695016cad7167254ce15966

- 数据集地址:https://huggingface.co/datasets/HuggingFaceTB/smollm-corpus

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END