EMO是一个由阿里巴巴发布的音频驱动的肖像视频生成框架。它能够通过单一参考图像和音频输入,生成具有丰富表情和多样头部姿势的虚拟角色视频。EMO利用先进的注意力机制和去噪网络,支持多语言和多种肖像风格的动态表现,为内容创作和虚拟角色动画制作提供了新工具。

EMO的功能特点

- 音频驱动的视频生成:根据输入的音频(如说话或唱歌)和参考图像,生成具有表情变化和头部动作的虚拟角色视频。

- 表情和动作同步:确保生成的视频中的角色表情和头部动作与音频输入的节奏和情感相匹配。

- 多语言支持:支持多种语言的音频输入,能够为不同语言的歌曲生成相应的表情和动作。

- 风格多样性:能够为不同的肖像风格(如历史画作、3D模型等)赋予动态和逼真的动作。

- 角色身份保持:在视频生成过程中保持角色的一致性和身份特征。

- 时间维度控制:可以根据输入音频的长度生成任意时长的视频。

- 跨文化和多语言应用:在多语言和多文化背景下,为角色提供表演和独白的能力。

这些功能使得EMO成为一个强大的工具,适用于内容创作、虚拟角色开发、动画制作和学术研究等领域。

EMO适用人群

- 内容创作者:对于希望将静态肖像转换为动态视频,尤其是带有特定表情和头部姿势的创作者来说,EMO提供了一种新的表达方式。

- 艺术家和设计师:艺术家和设计师可以使用EMO来探索新的艺术形式,将传统肖像艺术与现代技术结合,创造出独特的动态作品。

- 教育和娱乐行业专业人士:在教育和娱乐行业,EMO可以用来创造互动内容,如动态教材或角色驱动的故事叙述,增强用户体验。

- 研究人员和开发者:对于在音视频同步、人工智能和机器学习领域工作的研究人员和开发者,EMO提供了一个研究平台,用于探索和实验表情丰富的视频生成技术。

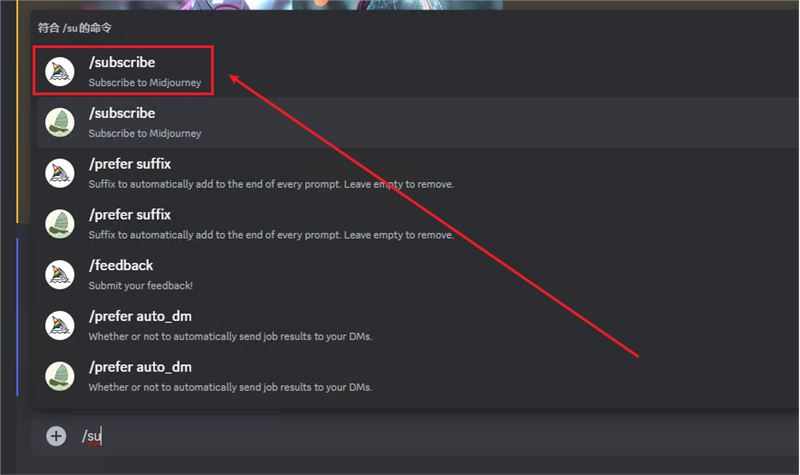

如何使用EMO?

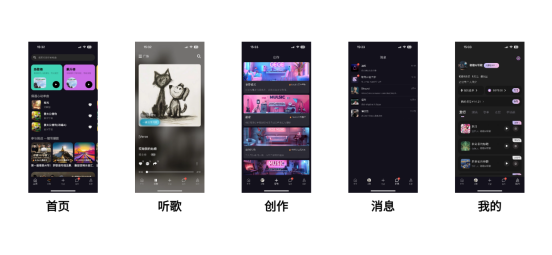

AIHub最新消息,EMO已经可以在通义千问APP使用了,如有兴趣,可前往各大应用商店下载,安装后在通义千问APP中搜索“全民唱演”即可体验。

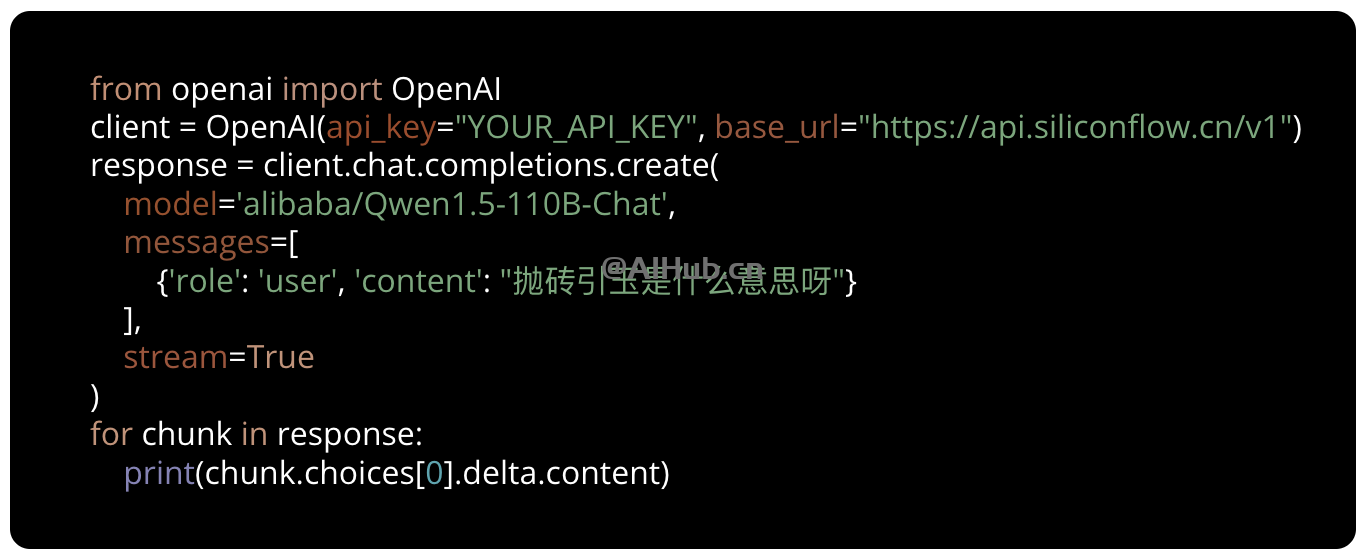

如果你是开发者或研究人员,可以访问下面资源,了解更多信息:

- 论文地址:arxiv.org/pdf/2402.17485.pdf

- 项目主页:humanaigc.github.io/emote-portrait-alive/

- GitHub地址:https://github.com/HumanAIGC/EMO

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END