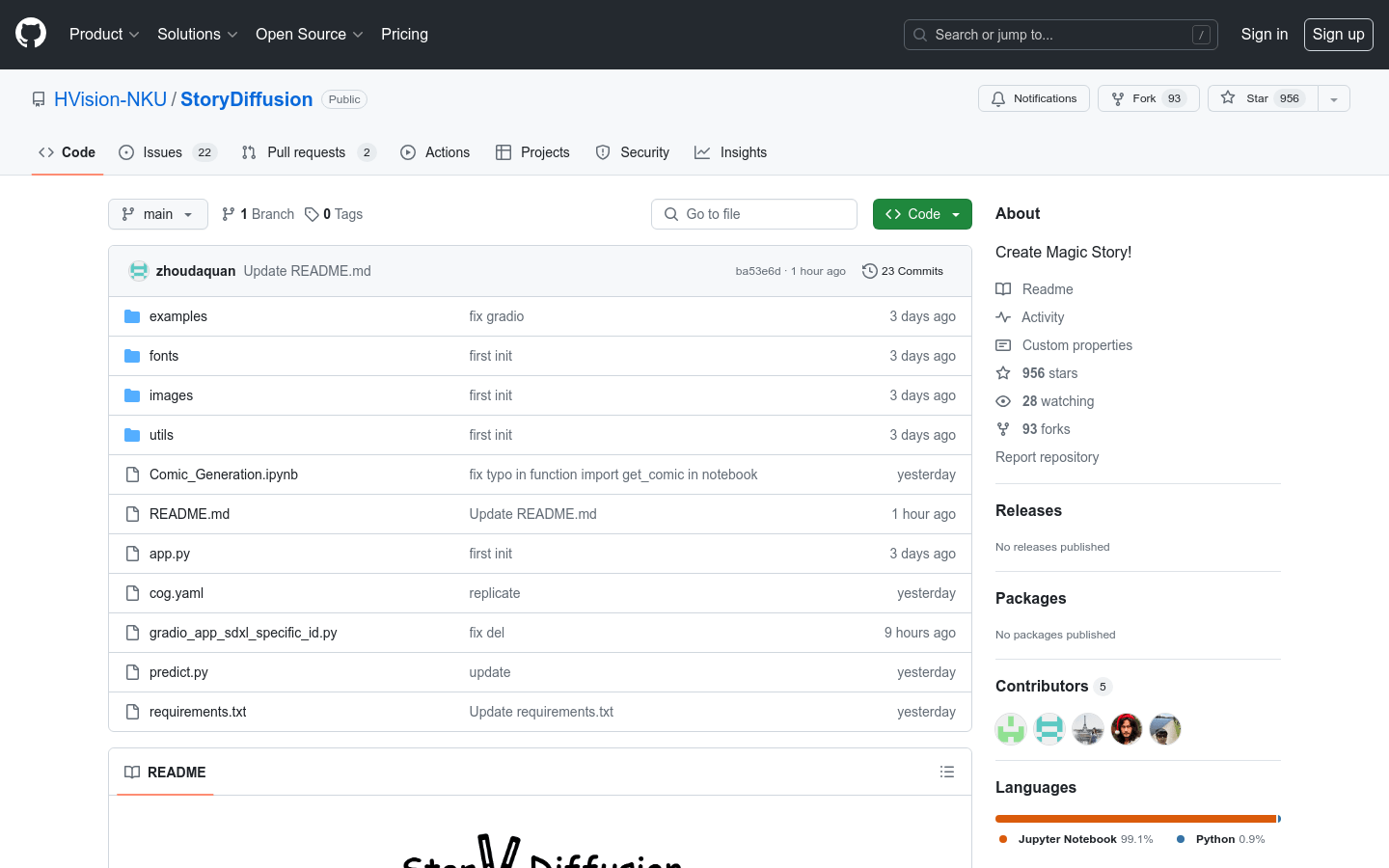

StoryDiffusion

StoryDiffusion 是一个开源的图像和视频生成模型,它通过一致自注意力机制和运动预测器,能够生成连贯的长序列图像和视频。这个模型的主要优点在于它能够生成具有角色一致性的图像,并且可以扩展到视频生成,为用户提供了一个创造长视频的新方法。该模型对AI驱动的图像和视频生成领域有积极的影响,并且鼓励用户负责任地使用该工具。

需求人群:

[“设计师:可以利用StoryDiffusion快速生成设计概念图。”,”视频制作者:可以用于生成视频内容的初步草图。”,”研究人员:可以用于AI图像和视频生成领域的研究。”,”爱好者:对于对AI艺术创作感兴趣的个人,StoryDiffusion 提供了一个实验和创造的平台。”]

使用场景示例:

使用StoryDiffusion生成一系列漫画风格的图像。

创建一个基于文本提示的长视频,展示一个连贯的故事。

利用StoryDiffusion进行角色设计和场景布局的预可视化。

产品特色:

一致自注意力机制:生成长序列中的角色一致图像。

运动预测器:在压缩的图像语义空间中预测运动,实现更大的运动预测。

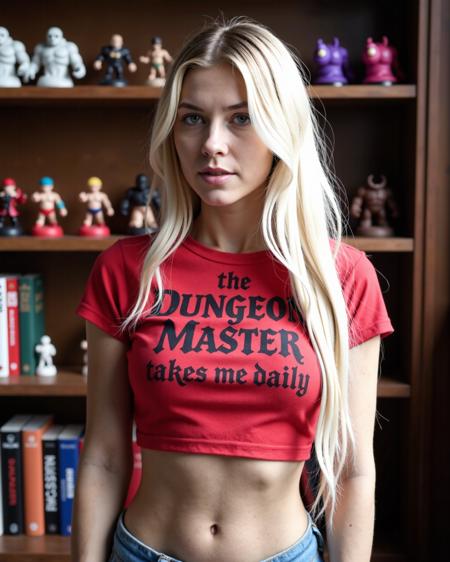

漫画生成:利用一致自注意力机制生成的图像,无缝过渡创建视频。

图像到视频的生成:提供用户输入的条件图像序列来生成视频。

两阶段长视频生成:结合两个部分生成非常长且高质量的AIGC视频。

条件图像使用:图像到视频模型可以通过提供一系列用户输入的条件图像来生成视频。

短视频生成:提供快速的视频生成结果。

使用教程:

步骤1:访问StoryDiffusion的GitHub页面并下载源代码。

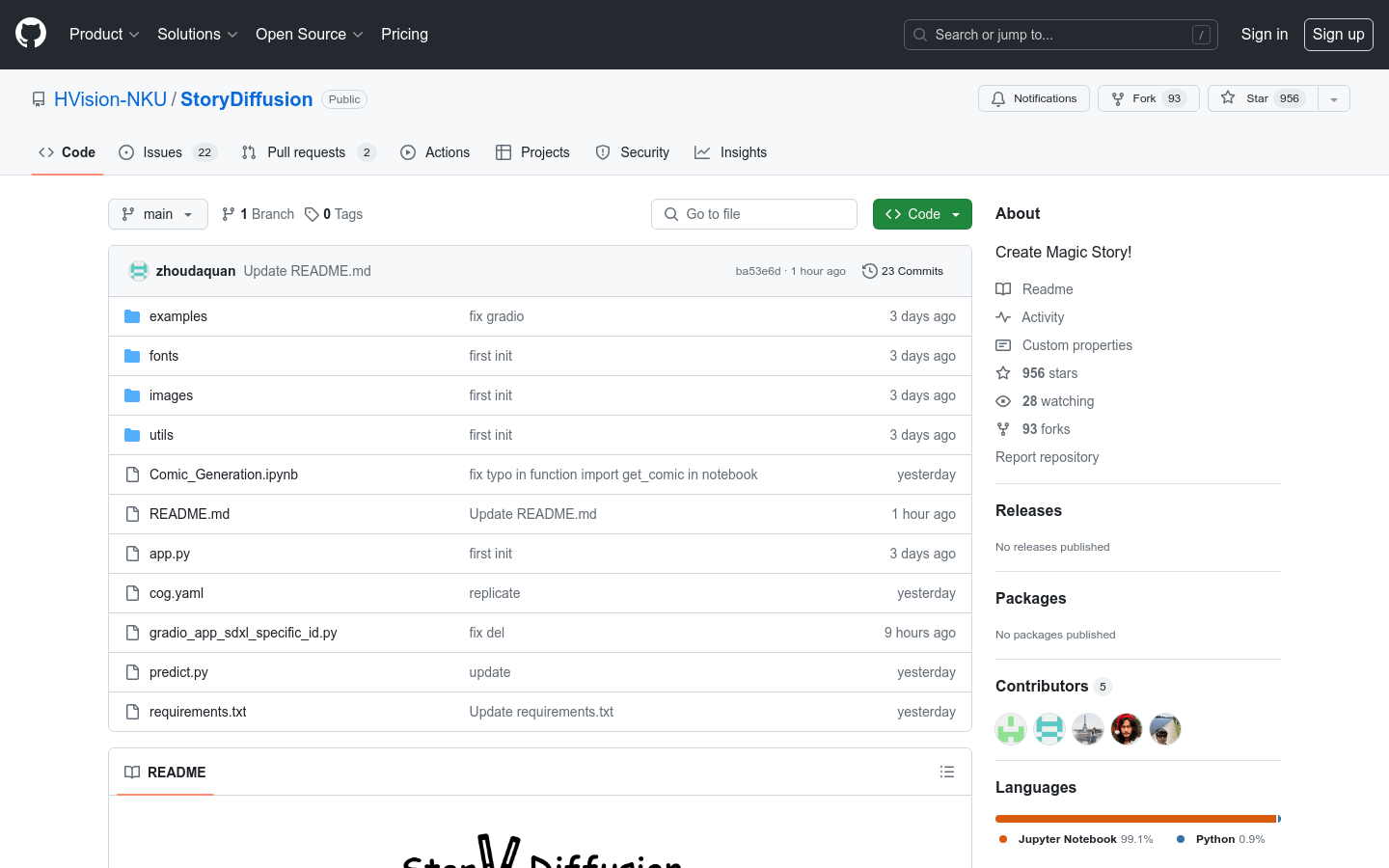

步骤2:确保你的计算机上安装了Python 3.8或更高版本,以及PyTorch 2.0.0或更高版本。

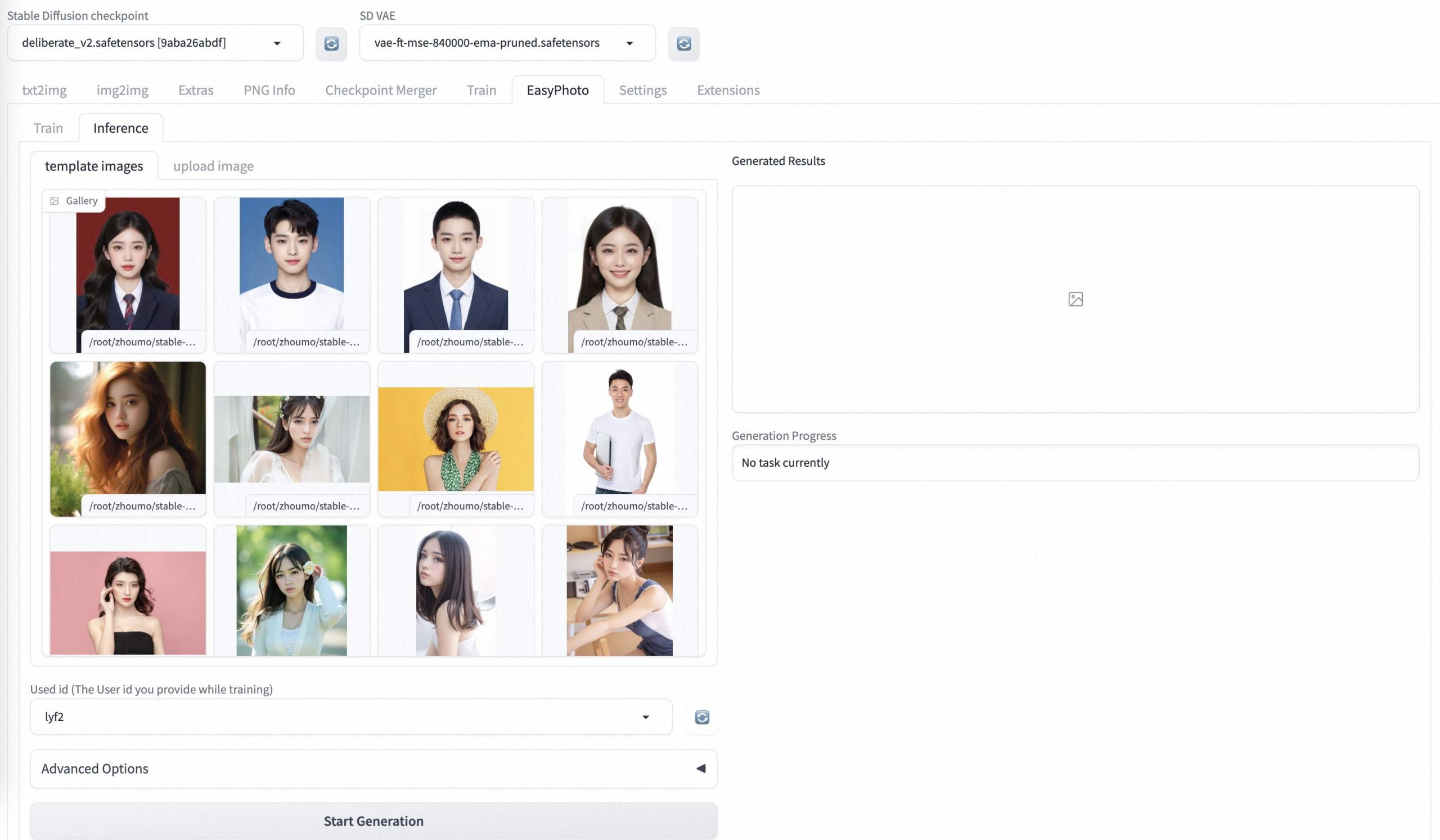

步骤3:通过运行提供的Jupyter notebook或启动本地gradio演示来生成漫画。

步骤4:根据需要提供至少3个文本提示给一致自注意力模块,以生成角色一致的图像。

步骤5:使用生成的图像作为条件图像,通过StoryDiffusion的图像到视频模型生成视频。

步骤6:调整和优化生成的图像和视频,以满足特定的创作需求。

龙跃AI 助手

龙跃AI 助手