Llama 3.1是Meta最新推出的开源大语言模型,有三种规格:8B(80亿)、70B(700亿)和405B(4050)亿参数,支持八种语言,具备128K扩展上下文长度。它提供卓越的通用知识、数学计算、多语言翻译和工具使用能力,开放下载并允许开发者定制和微调。Llama 3.1还包括增强的安全工具和广泛的合作伙伴支持,适用于多种AI应用开发。

Llama 3.1的主要特性

Llama 3.1的主要特性

- 参数规模:Llama 3.1包含三种规格:80亿、700亿和4050亿参数,4050亿参数是Llama系列中最强大的模型,具备顶尖的通用知识、数学计算、多语言翻译和工具使用能力,提升了模型的细致性和复杂任务处理能力。

- 上下文长度:128K上下文长度,能够处理更长的文本输入,适用于长文本摘要、复杂对话和多步骤问题解决,提升了模型在长文本处理中的表现。

- 多语言支持:支持包括英语、中文、西班牙语、法语、德语、日语、韩语和阿拉伯语在内的八种语言,增强了模型的全球适用性,适用于多语言翻译和跨语言处理。

- 模型下载和定制:Llama 3.1模型可以从Meta官方网站和Hugging Face平台公开下载,允许开发者进行自定义训练和微调,适应各种应用场景,推动AI技术的普及和创新。

- 高性能和高效训练:在超过15万亿个标记上进行训练,并使用超过16,000个H100 GPU进行优化,确保模型的高性能和高效能。预训练数据日期截止到2023年12月。

- 量化技术:为了应对405B模型的运行需求,Meta把模型数据从16位(BF16)量化减少到8位(FP8),大幅降低了计算资源的需求,令模型能够在单一服务器节点上运行。

- 增强的安全和防护措施:提供了 Llama Guard 3 和 Prompt Guard 等安全工具,以及 Llama Stack API 的评论请求,旨在促进第三方项目更容易地利用 Llama 模型。

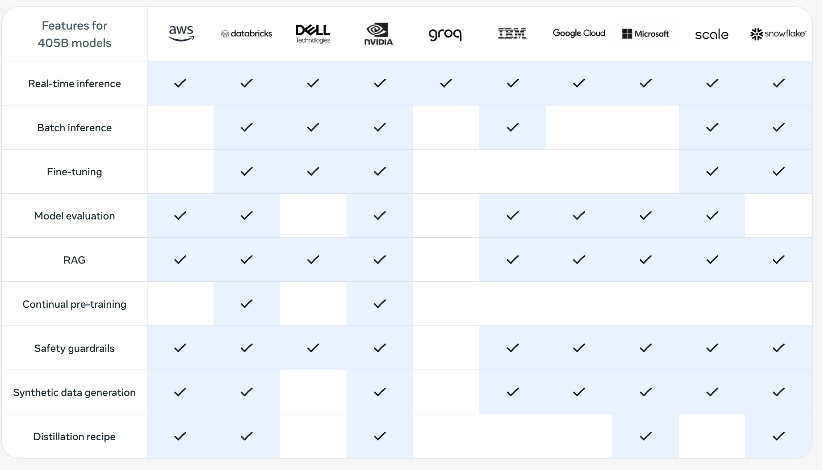

- 广泛的生态系统支持:Meta 改进了模型的训练和微调流程,以及模型的推理和部署方式,以便更广泛地支持开发者和平台提供商,包括AWS、NVIDIA、Google Cloud等25个合作伙伴提供的即用服务,确保无缝的开发和部署体验。

Llama 3.1的性能评测

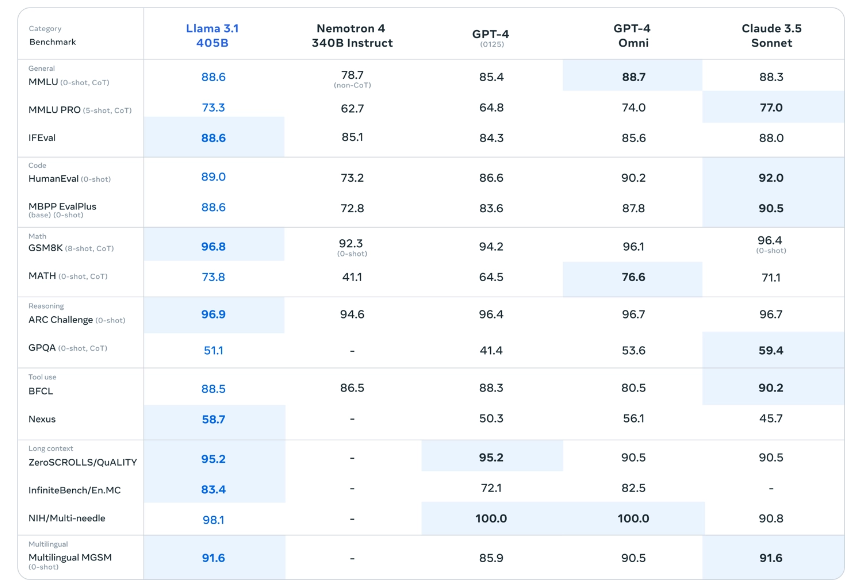

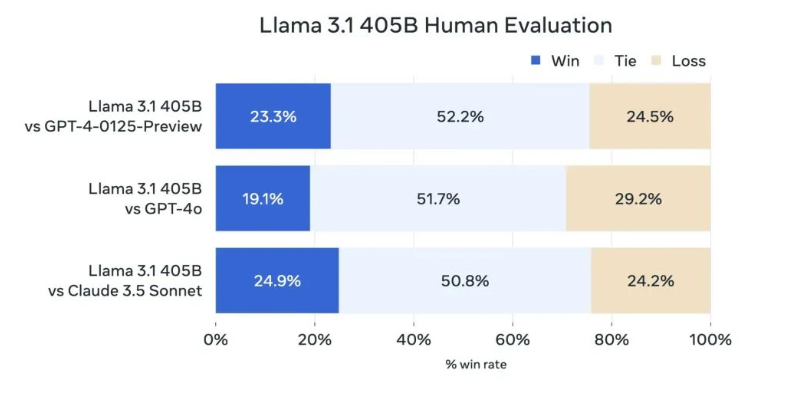

Meta 称 4050 亿参数的 Llama 3.1-405B 在常识、可引导性、数学、工具使用和多语言翻译等一系列任务中,可与 GPT-4、GPT-4o、Claude 3.5 Sonnet 等领先的闭源模型相媲美。

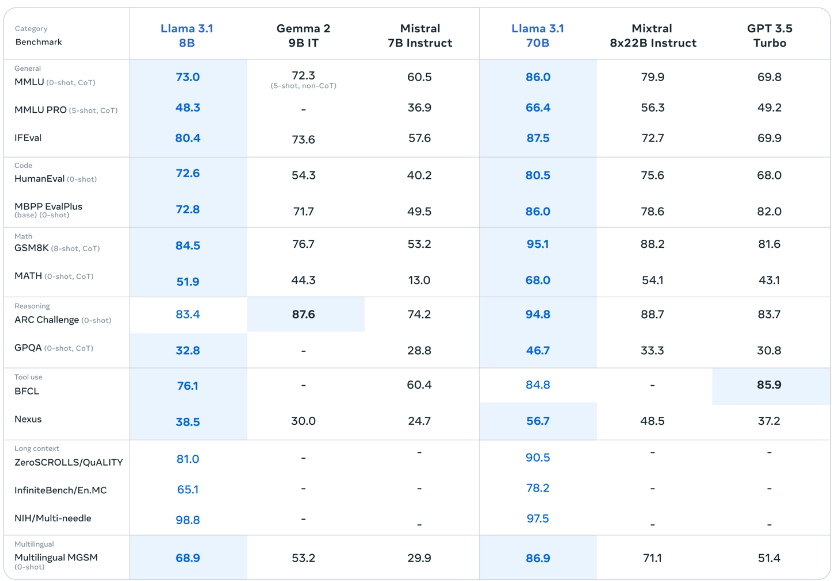

此外,8B 与 70B 参数的 Llama 3.1 模型与其他参数量相似的闭源和开源模型相比,也同样具有竞争力。

此外,8B 与 70B 参数的 Llama 3.1 模型与其他参数量相似的闭源和开源模型相比,也同样具有竞争力。

如何使用Llama 3.1?

Llama 3.1 现已于 Meta 官网和 Hugging Face 开放下载,包括 AWS、英伟达、戴尔、Azure 和 Google Cloud 在内的超过 25 个合作伙伴也已经准备就绪。

- 模型官网:https://llama.meta.com/

- 模型下载:https://llama.meta.com/llama-downloads

- 博客文章:https://ai.meta.com/blog/meta-llama-3-1/

- HuggingFace地址:https://huggingface.co/collections/meta-llama/llama-31-669fc079a0c406a149a5738f

- GitHub项目:https://github.com/meta-llama/llama-models

25 个合作伙伴

25 个合作伙伴© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END