GPT-4o是OpenAI推出的最新一代大型语言模型,它集合了文本、图片、视频、语音的全能模型,能够实时响应用户需求,并通过语音进行实时回答。GPT-4o具有强大的逻辑推理能力,其速度是前代模型GPT-4 Turbo的两倍,而成本降低了50%。

GPT-4o是迈向更自然的人机交互的一步——它接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像输出的任意组合。它可以在短短 232 毫秒内响应音频输入,平均为 320 毫秒,这与对话中的人类响应时间相似。它在英语文本和代码上的 GPT-4 Turbo 性能相匹配,在非英语语言的文本上也有显着改进,同时在 API 中也更快且便宜 50%。与现有模型相比,GPT-4o 在视觉和音频理解方面尤其出色。

GPT-4o的主要功能

GPT-4o的主要功能

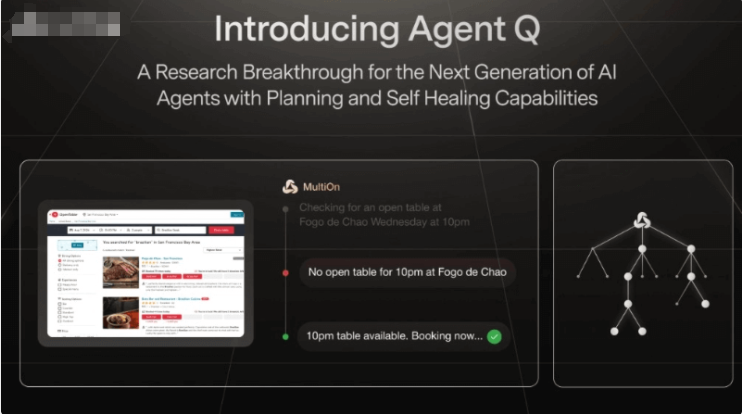

- 多模态输入与输出:GPT-4o能够处理文本、音频和图像输入,并生成这些形式的任意组合输出,提升了与计算机的自然交互能力。

- 实时对话反馈:GPT-4o提供快速响应,音频输入的平均响应时间为320毫秒,与人类对话反应时间相近。

- 情感识别与模拟:GPT-4o能够识别用户的情感状态,并在语音输出中模拟相应的情感。

- 多语言支持:GPT-4o支持超过50种语言,并提供实时同声传译。

GPT-4o的性能表现

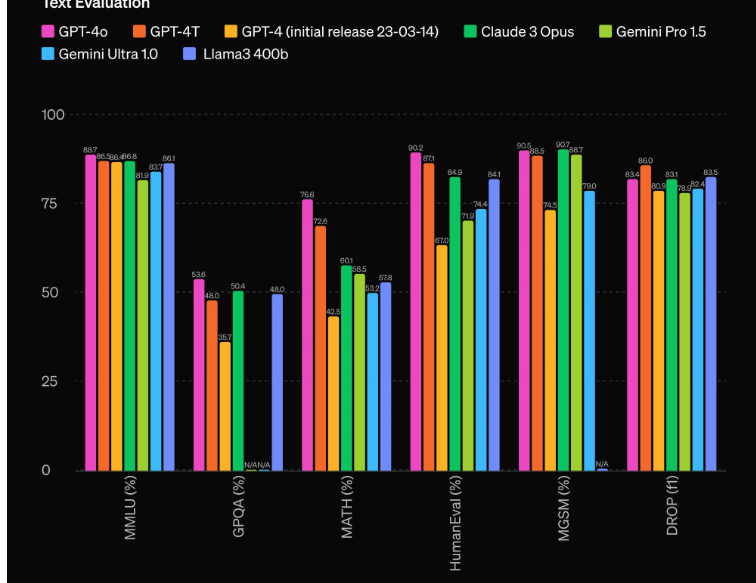

文本性能评估:

- GPT-4o在多语言理解均值(MMLU)基准测试中达到了88.7%的得分,显示出其在多语言处理上的卓越能力。

- 在GPQA(General Language Question Answering)测试中得分为53.6%,排名第一。

- 在MATH(Math Question Answering)测试中得分为76.6%,排名第一。

- 在HumanEval测试中得分为90.2%,排名第一。

- 在MGSM(Massive Generalized Semantics Meaning)测试中得分为90.5%,排名第二,略低于Claude 3 Opus。

音频性能:

音频性能:

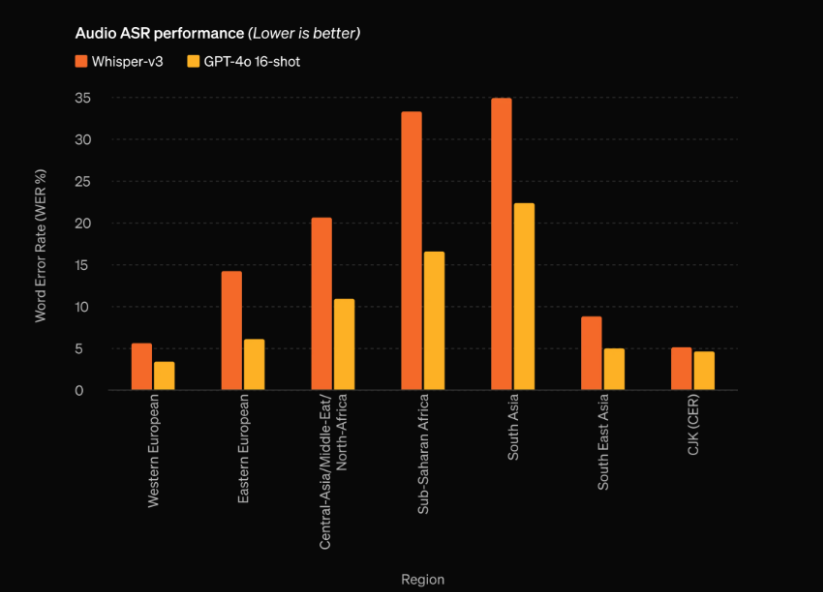

在音频自动语音识别(ASR)性能方面,GPT-4o显著提高了所有语言的语音识别性能,特别是对资源匮乏的语言。

音频翻译性能:

音频翻译性能:

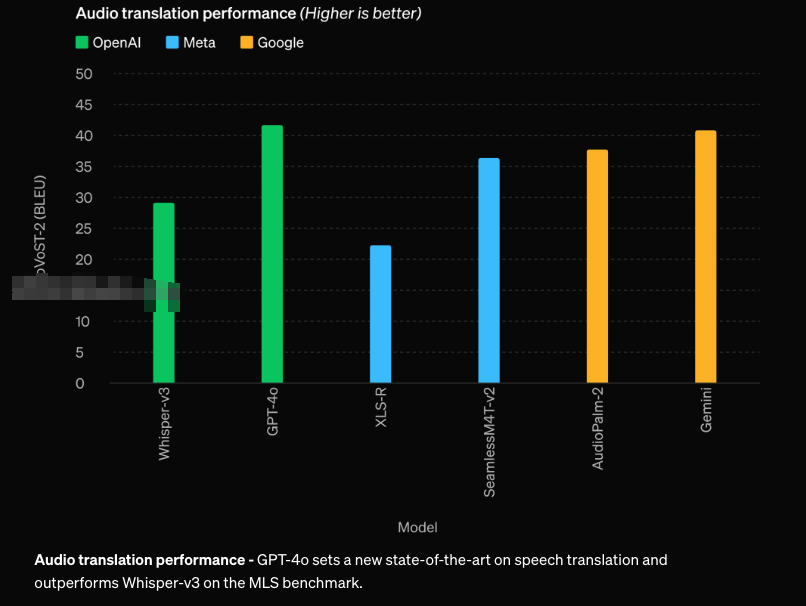

GPT-4o在语音翻译方面达到了新的最先进水平,在MLS(多语言语音)基准测试中优于Whisper-v3,超越了Meta的SeamlessM4T-v2和谷歌的Gemini。

视觉理解评估:

视觉理解评估:

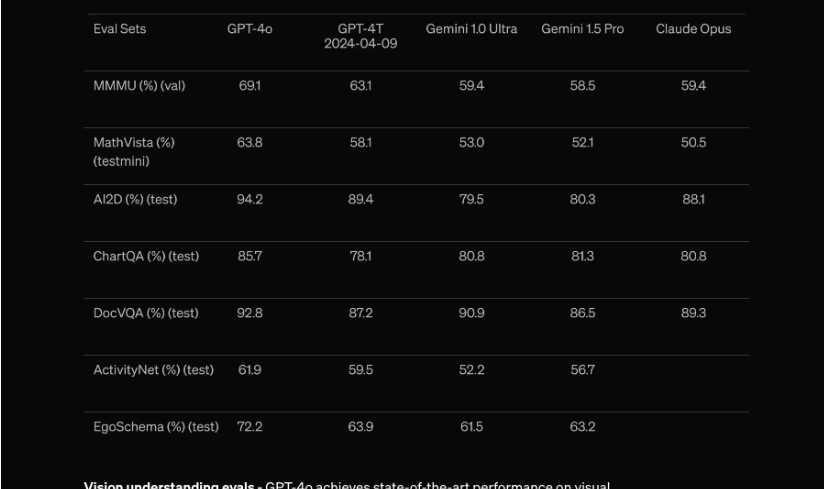

GPT-4o在视觉感知基准上实现了最先进的性能(SOTA),超过了Gemini 1.0 Ultra、Gemini 1.5 Pro和Claude 3 Opus。

GPT-4o的API价格

GPT-4o的API价格

GPT-4o的API价格相比GPT-4 Turbo有显著的优势:

价格:GPT-4o的价格比GPT-4 Turbo便宜50%。具体到API的定价,输入和输出的标记(tokens)价格分别为:

- 输入:$5.00 / 1M tokens

- 输出:$15.00 / 1M tokens

对比看一下GPT-4 Turbo:

- 输入:$10.00 / 1M tokens

- 输出:$30.00 / 1M tokens

速率限制:GPT-4o的速率限制是GPT-4 Turbo的5倍,这意味着用户可以在一分钟内处理高达1000万个token,这对于需要处理大量数据的应用来说是一个巨大的优势。

如何使用GPT-4o?

个人用户:

GPT-4o的文本和图像能力今天开始在ChatGPT中推出。在免费版中提供GPT-4o,并为Plus用户提供高达5倍的消息限制。在未来几周内,将在ChatGPT Plus中推出带有GPT-4o的语音模式新版本。

在ChatGPT中免费使用:https://chat.openai.com/

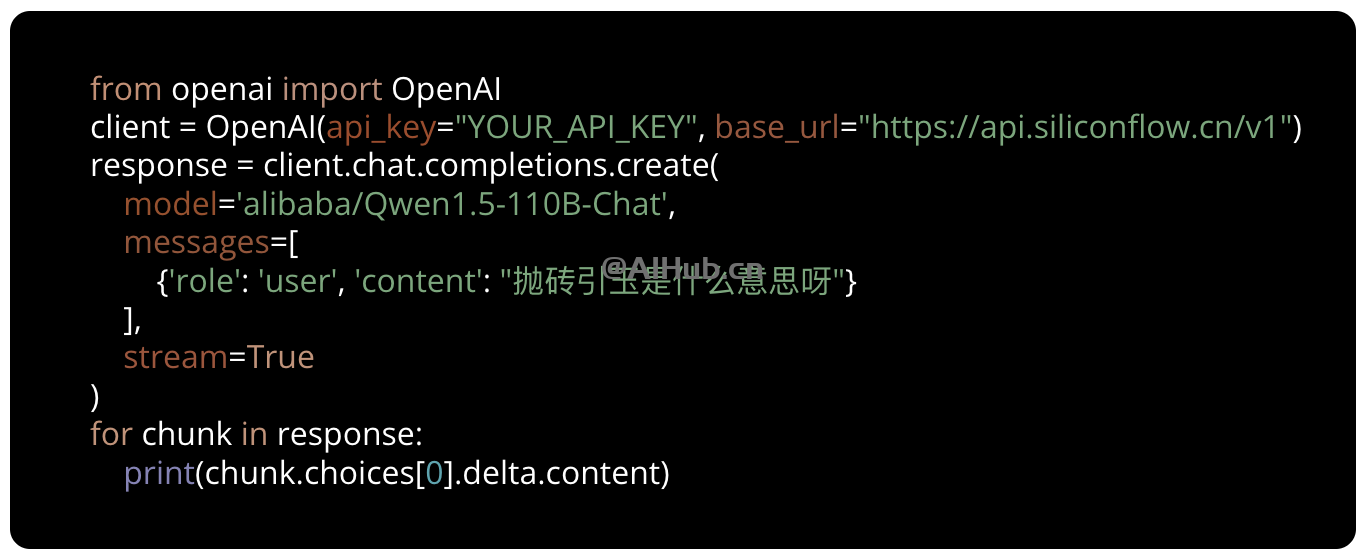

开发人员:

开发者现在也可以通过API以文本和视觉模型的形式访问GPT-4o。与GPT-4 Turbo相比,GPT-4o的速度提高了2倍,价格降低了一半,速率限制提高了5倍。OpenAI计划在未来几周内向API中的一小部分信任合作伙伴推出对GPT-4o的新音频和视频能力的支持。

了解更多信息,前往GPT-4o官网:https://openai.com/index/hello-gpt-4o/