DiffusionRL

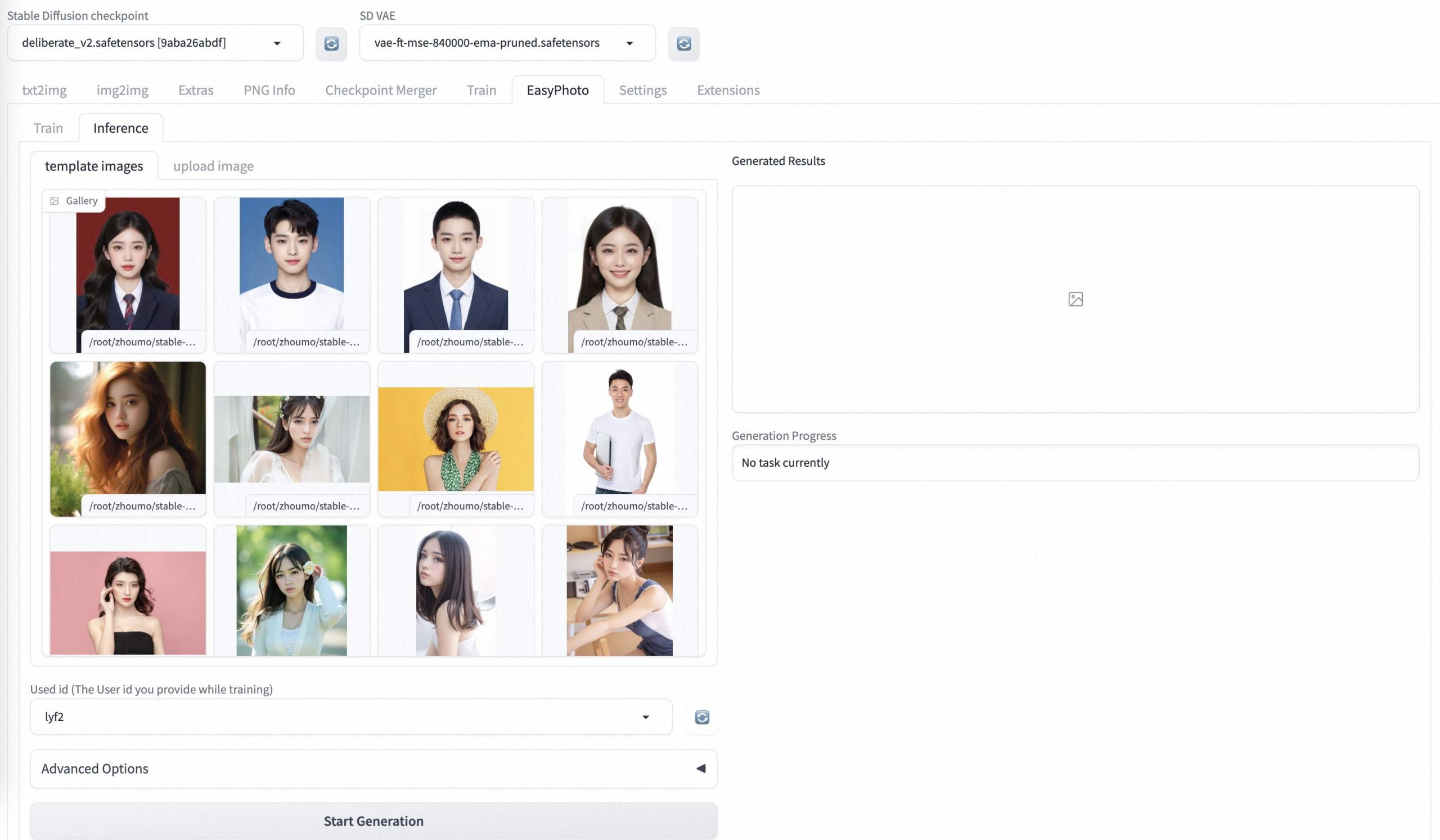

Text-to-image扩散模型是一类深度生成模型,展现了出色的图像生成能力。然而,这些模型容易受到来自网页规模的文本-图像训练对的隐含偏见的影响,可能无法准确地对我们关心的图像方面进行建模。这可能导致次优样本、模型偏见以及与人类伦理和偏好不符的图像。本文介绍了一种有效可扩展的算法,利用强化学习(RL)改进扩散模型,涵盖了多样的奖励函数,如人类偏好、组成性和公平性,覆盖了数百万张图像。我们阐明了我们的方法如何大幅优于现有方法,使扩散模型与人类偏好保持一致。我们进一步阐明了如何这显著改进了预训练的稳定扩散(SD)模型,生成的样本被人类偏好80.3%,同时改善了生成样本的组成和多样性。

需求人群:

“适用于改进文本到图像扩散模型的生成效果,提高图像的人类偏好、组成性和多样性。”

使用场景示例:

通过DiffusionRL改进了文本到图像扩散模型,提高了图像生成的质量。

DiffusionRL应用于改进了稳定扩散模型,使生成的样本更符合人类偏好。

利用DiffusionRL的强化学习算法,改进了扩散模型的生成效果,提高了图像的多样性。

产品特色:

改进扩散模型

使用强化学习对扩散模型进行改进

涵盖多样的奖励函数

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

龙跃AI 助手

龙跃AI 助手