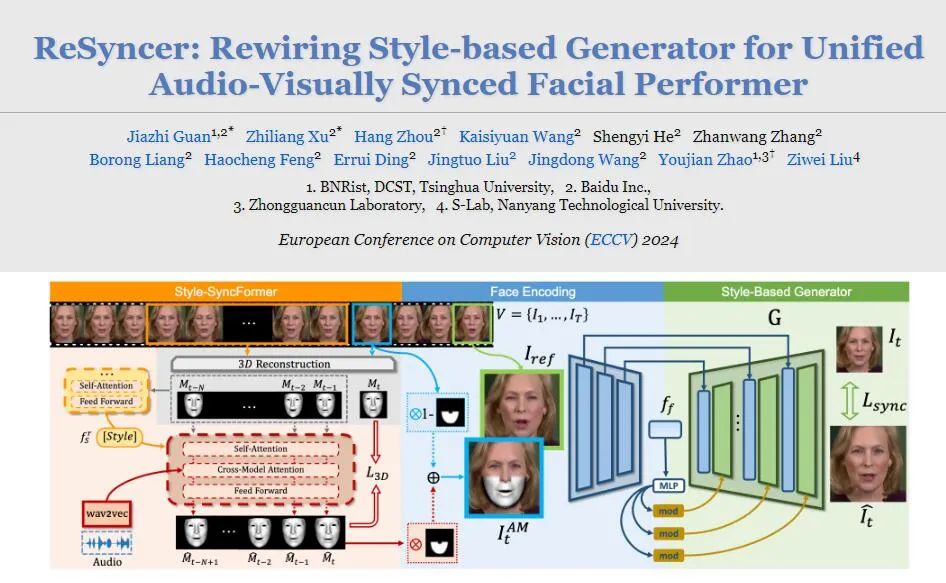

清华大学、百度和南洋理工大学S-Lab实验室联合开发了一种新型的多功能AI框架——ReSyncer,它在视频合成技术领域取得了显著的突破。

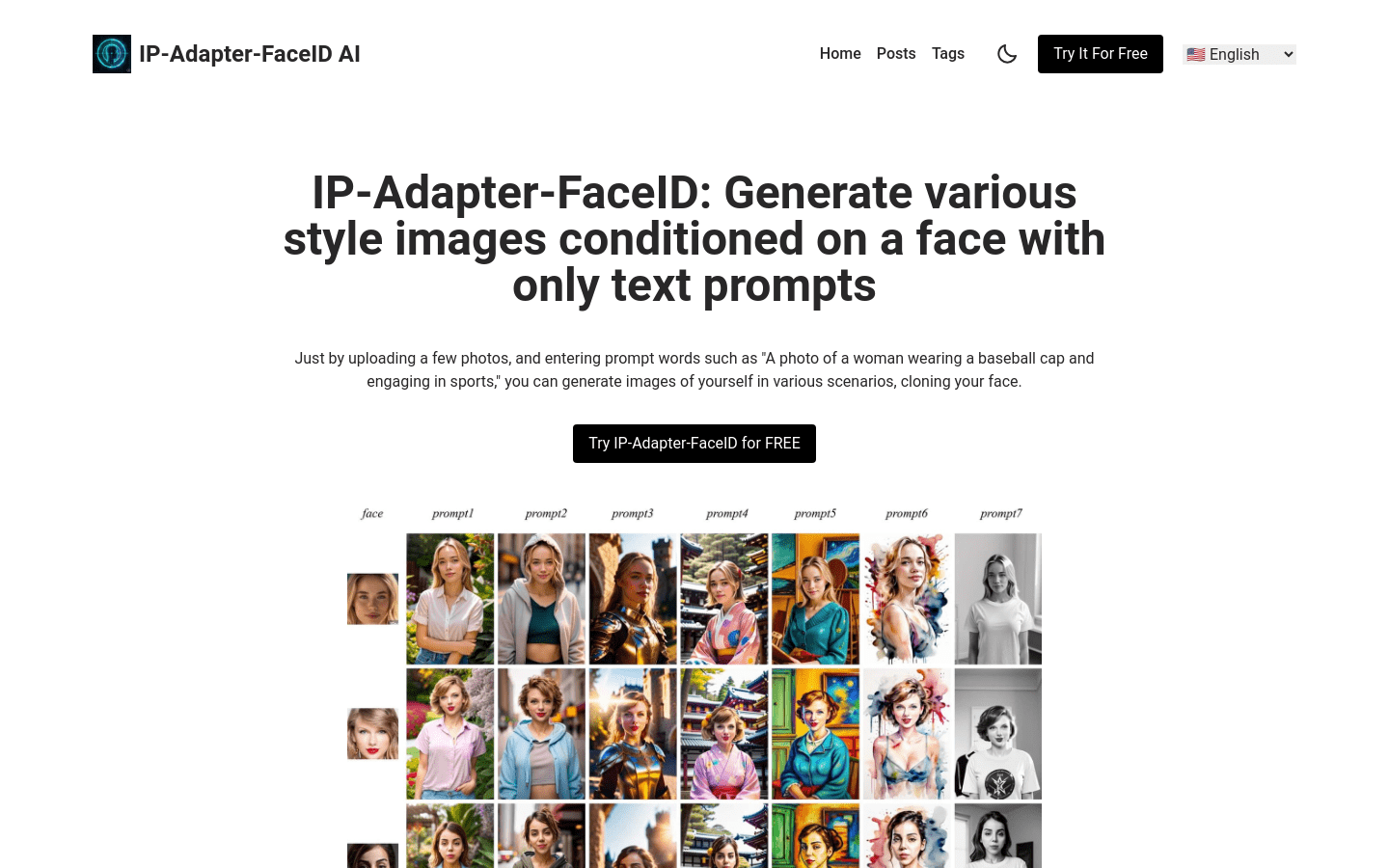

ReSyncer能够生成与音频高度同步的逼真口型视频,同时具备个性化调整、视频驱动口型同步、说话风格迁移和人脸交换等多种先进功能。

ReSyncer的核心优势在于其多样化的功能集成。它不仅能生成与音频高度同步的逼真口型视频,还具备个性化调整、视频驱动口型同步、说话风格迁移和人脸交换等先进功能。这种多功能性使得ReSyncer在各种应用场景中都能发挥出色的表现。

最引人注目的是ReSyncer在音视频同步方面的卓越表现。通过先进的AI算法,它能够制作出精确跟随音频的嘴部动作视频,为观众带来前所未有的真实感。

这项技术不仅提升了视频的观看体验,也为电影配音、多语言内容制作等领域提供了新的可能性。

ReSyncer的个性化微调功能更是赋予了创作者无限的想象空间。用户可以根据具体需求,对生成的视频内容进行细致调整,使最终成品更贴合特定场景和个人喜好。这种灵活性无疑将大大提高内容创作的效率和质量。

而视频驱动的口型同步功能则进一步拓展了ReSyncer的应用范围。它允许新视频中的角色模仿已有视频中的说话动作,为视频编辑和内容创作提供了更多创新可能。

想象一下,你可以让历史人物”说出”现代的话语,或者让动画角色完美复刻真人的口型动作,这些曾经只存在于科幻电影中的场景,如今都变为了现实。

Video PlayerReSyncer的说话风格迁移功能更是一大亮点。它能够将一个人的说话风格,包括语气和节奏,迁移到另一个人身上。这项技术在语言教学、配音表演、甚至是个性化虚拟助手的开发中都有着广泛的应用前景。

ReSyncer强大的人脸交换功能更是为视频制作提供了革命性的解决方案。它不仅能在视频中无缝替换说话者的面部,还能保持口型与音频的完美同步。

这项技术的应用将极大地简化电影特效制作的流程,同时也为个人创作者提供了前所未有的创意工具。

然而,如此强大的技术也引发了一些伦理和法律方面的讨论。如何防止这项技术被用于制作虚假信息或侵犯他人肖像权,将是未来需要社会各界共同面对的挑战。

ReSyncer是一个创新的框架,致力于通过先进的风格注入Transformer技术,实现音频与视频的高效同步。它不仅能够生成高保真的唇形同步视频,还支持快速个性化微调、视频驱动的唇形同步、说话风格的转换,甚至面部交换等特性。这些功能对于创建虚拟主持人和表演者至关重要,能够显著提升视频内容的自然度和真实感。

需求人群:

“ReSyncer的目标受众主要是视频制作者、虚拟角色设计师以及相关领域的研究人员。它能够帮助这些用户在制作虚拟主持人、动画角色或者进行面部动作捕捉时,实现更加自然和逼真的音视频同步效果。”

使用场景示例:

用于创建虚拟新闻主播,提升新闻播报的自然度。

在动画电影制作中,实现角色的面部表情与配音的精确同步。

在虚拟现实应用中,为虚拟角色提供更加真实的面部动作和表情。

产品特色:

高保真唇形同步视频生成

快速个性化微调功能

视频驱动的唇形同步

说话风格的转换

面部交换技术

统一训练融合动作与外观

使用教程:

1. 准备音频和目标视频素材。

2. 根据ReSyncer的框架要求,对音频进行预处理,提取关键的音频特征。

3. 将音频特征与视频素材输入到ReSyncer模型中。

4. 利用ReSyncer的统一训练机制,进行唇形同步的生成。

5. 根据需要,对生成的视频进行微调,以满足特定的个性化需求。

6. 导出最终的唇形同步视频,用于进一步的视频编辑或直接发布。

项目地址:https://guanjz20.github.io/projects/ReSyncer/?ref=top.aibase.com

龙跃AI 助手

龙跃AI 助手

暂无评论内容