Tencent EMMA

EMMA是一个基于最前沿的文本到图像扩散模型ELLA构建的新型图像生成模型,能够接受多模态提示,通过创新的多模态特征连接器设计,有效整合文本和补充模态信息。该模型通过冻结原始T2I扩散模型的所有参数,并仅调整一些额外层,揭示了预训练的T2I扩散模型可以秘密接受多模态提示的有趣特性。EMMA易于适应不同的现有框架,是生成个性化和上下文感知图像甚至视频的灵活有效工具。

需求人群:

“目标受众包括图像生成领域的研究者、开发者和艺术家,他们需要一个能够理解并融合多种输入条件来创造高质量图像的工具。EMMA的灵活性和高效性使其成为这些用户的理想选择,尤其是在需要快速适应不同生成框架和条件时。”

使用场景示例:

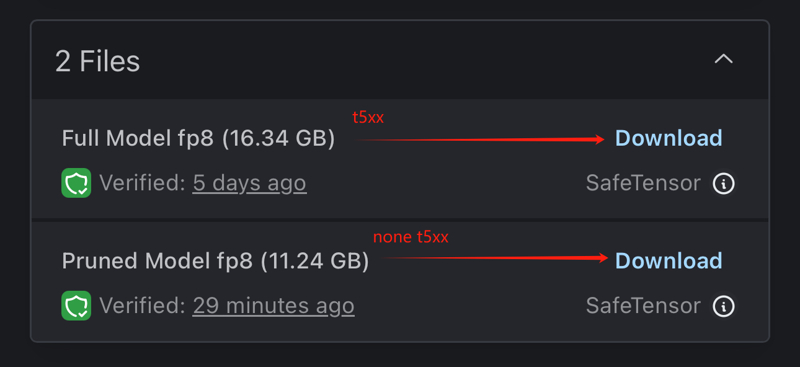

使用EMMA结合ToonYou生成不同风格的图像

结合AnimateDiff模型生成保留肖像细节的图像

生成具有故事情节的图像集,如女子被狗追逐的故事

产品特色:

接受文本和参考图像等多模态提示

通过特殊的注意力机制整合文本和补充模态信息

冻结原始T2I扩散模型参数,仅调整额外层以适应多模态

无需额外训练即可处理不同的多模态配置

生成高保真度和细节丰富的图像

适用于生成个性化和上下文感知的图像及视频

使用教程:

1. 访问EMMA产品页面并了解基本介绍

2. 阅读技术文档,了解模型的工作原理和特点

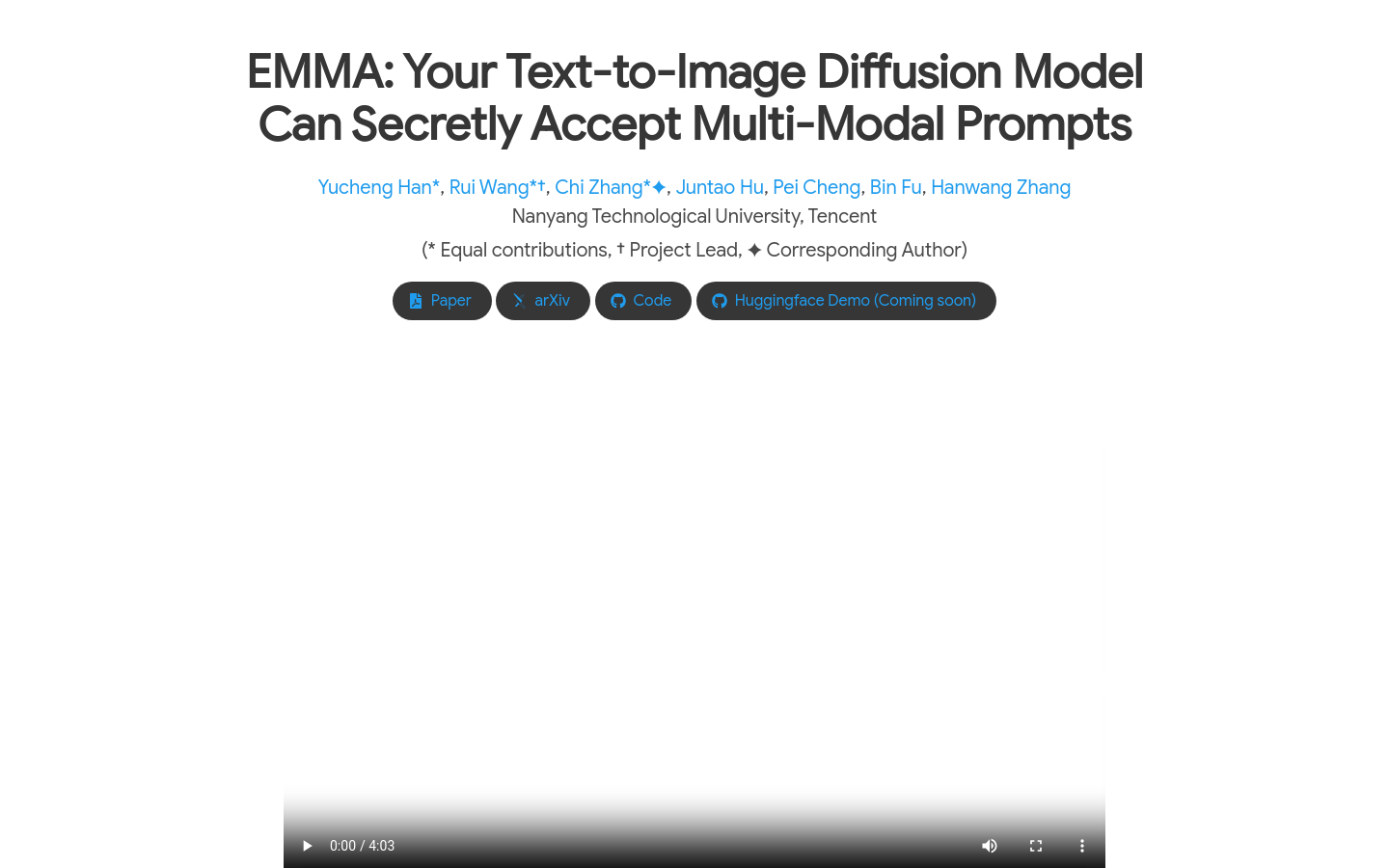

3. 下载并安装必要的软件依赖,如Python环境和相关库

4. 根据示例代码或文档指导,编写自己的多模态提示

5. 运行EMMA模型,输入文本和参考图像等提示

6. 等待模型生成图像,评估生成结果并进行必要的调整

7. 根据需要,将生成的图像应用于艺术创作或研究项目中

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

龙跃AI 助手

龙跃AI 助手