—- 本周为您解读 ③ 个值得细品的 AI & Robotics 业内要事 —-

1. RL「误人」?LeCun 在技术路线上又有何战略摇摆?

Karpathy 为何「悔做 RL」?LeCun 是如何评价 RL 的?LeCun 推崇的关键技术有过几轮变化?Energy-Based SSL 和世界模型有什么关系?什么是 Objective-Driven AI?…2.大半年过去,主流视频生成模型们超越Sora 了吗?

Sora 发布大半年之后,主流的文生视频模型表现如何?类 Sora 模型们追上了吗?T2V 模型目前面临的共同挑战有哪些?T2V 领域有哪些关键技术进展?AI 视频生成应用距离「好用」还有多远?…3. 2025 IT 优先事项报告:在产线中集成 AI 是保持竞争力的关键

为何在产线集成 AI 是企业 2025 年最优先事项?企业 IT 领导还关注哪些高优先任务?AI 的投资回报率上涨了吗?为什么 AI+FinOps 火了?企业的 AI 预算涨了吗?…

…本期完整版通讯含 3 项专题解读 + 30 项本周 AI & Robotics 赛道要事速递,其中技术方面 10 项,国内方面 10 项,国外方面 10 项。

本期通讯总计 24189 字,可免费试读至 9%

消耗 99 微信豆即可兑换完整本期解读(约合人民币 9.9 元)

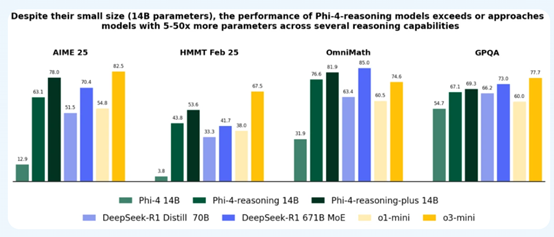

要事解读① RL「误人」?LeCun 在技术路线上又有何战略摇摆?引言:Andrey Karpathy 近日有关「悔做 RL」的言论引起许多关注,而他在后悔的同时对 Yann LeCun 从一开始就不看好强化学习的态度始终正确的说法引发了 AI 社区对另一件事的兴趣,即「LeCun 的 AI 战略是否出现过摇摆?」LeCun 推崇技术的更替了解一下?1、OpenAI 创始成员、研究科学家、原特斯拉前 AI 高级总监 Andrej Karpathy 近期在社交平台上有关「悔做 RL」的评论引起了极大关注,他将自己在 OpenAI 选择强化学习而没有选择自回归语言模型的决策描述为「有史以来最大、最令人困惑的研究生涯错误」。[1]① Karpathy 所描述的「弯路」在于他早期对语言模型的潜力有所认识,但后来却将研究重心转向了强化学习,没有持续在语言模型这一方向上深耕。② 在 2015 年前后,当时普遍看法认为 RNN 难以训练,但 Karpathy 在 2015 年的文章《RNN 的不合理有效性》中探讨了循环神经网络(RNN)的潜力,并通过实验展示了 RNN 在文本生成、代码生成等方面的能力。2、Karpathy 提到 Yann LeCun 当时对强化学习持保留态度,并用「蛋糕」比喻来说明强化学习在整个 AI 领域中的次要地位,而 Karpathy 认为 LeCun 在概念上一直是正确的。[1]3、相比于 Karpathy 的「悔恨」,知名 AI 学者、图灵奖得主 Yann LeCun 对其所推崇的技术路线十分坚定。在他历年的学术大会和访谈等公开场合分享的观点中,LeCun 始终强调实现人类水平智能不可能是监督学习或纯强化学习,他所推崇的技术也在这条主线上逐步更迭。① 2016 年,LeCun 强调无监督学习「根据任何可用信息预测过去、现在或未来的任何部分感知」的能力可以填补机器学习不具备预测能力的空白,并将其比喻为一个蛋糕的主体。[2]② 2019 年,LeCun 用「自监督学习」取代了「无监督学习」,并预测未来的神经网络是拥有大量数据和超大网络的自监督学习。[3]③ 2019 年末,LeCun 在 SSL 是未来的基础上开始推崇能量模型,即 Energy-Based SSL,而后强调能量模型和世界模型对下一代 AI 的重要性。[4]④ 2023 年,LeCun 在实现人类水平的 AI 的必要条件清单中增加了 Objective-DrivenAI 架构,与世界模型、能量模型和其他组件共同构成了自主智能(autonomous intelligence)的大框架。[5]

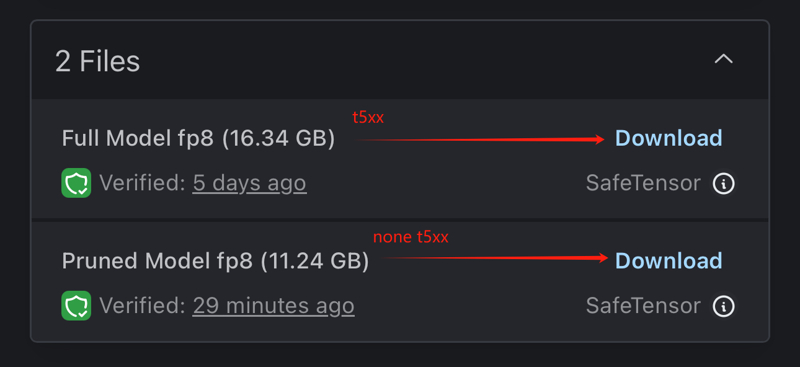

图:LeCun 历年推崇的关键技术。[2] -[5]

让 LeCun 放弃无监督的 Energy-Based SSL 和世界模型有什么关系?Yann LeCun 在 2016 年的 NIPS(现在的 NeuRIPS)大会上首次提出了「蛋糕比喻」,他将智能(Intelligence)比作一个蛋糕,其中大部分蛋糕(主体)是无监督学习,蛋糕上的糖霜(小部分)是监督学习,蛋糕上的樱桃(极小部分)是强化学习(RL)。[2] 这个比喻在 AI 社区中广为流传,并确立了 LeCun 作为无监督学习的坚定支持者。1、LeCun 一直在强调,人类会利用预测和推理等能力从可用信息中推断未来,而非通过筛选大量标记数据来理解世界。无监督学习或预测学习可以弥补当前 AI 在推理不同对象之间的关系或预测人类动作等方面的空白。① 在 2019 年 5 月的 ISSCC 大会中,LeCun 开始重新表述他的观点,给予了自监督学习(SSL)更高的评价,认为这种特殊的无监督学习方式是构建人工智能未来的重要因素,并在后续逐步提出了围绕 SSL 的一系列新概念。[3]2、相较于对无监督学习/自监督学习的重视,LeCun 在历年的演讲和访谈等场合均表达了对(纯)强化学习方法的不看好。虽然该论调持续吸引了许多来自 RL 社区的反击,但他的态度始终没有改变。[7]① LeCun 认为强化学习需要过多(Insane Amounts)的实验来学习,存在样本利用率低、过度依赖大量训练数据等局限,且仅完成特定目标后给予奖励,缺少对过程的反馈。② LeCun 没有否认 RL 的价值,他列举了 RL 当时在各类游戏中取得的成就。然而,他认为在简单的虚拟世界中有效的 RL 无法实时且并行地在真实世界中运行,这与人类学习的方式存在显著差异,不适用大多数真实世界场景,因此建议将 RL 视为最后的选择,即蛋糕上的樱桃。3、2019 年 5 月在 ISSCC 的演讲中,LeCun 将下阶段 AI 所需的核心技术从无监督学习改为了 SSL,后在在该年 9 月,他 UCLA 的演讲中重点介绍了 Energy-Based SSL,即能量模型(EBM)。[3] [4]① EMB 在机器学习领域并不是新概念,但随着相关研究的深入,能量模型的可行性和应用前景在不断提升。EBM 提供了一种新的视角,允许人们放弃对概率模型的依赖,转而关注能量函数本身,从而简化模型的构建和训练过程。

龙跃AI 助手

龙跃AI 助手

暂无评论内容