笔者尝试AI视频生成的几个特点:

- – 玄学prompt,每个视频的prompt可能也需要微调很多次,需要找到使用模型的最佳prompt词组合,不恰当的比喻,骑自行车,座位高度等都是人与车彼此熟悉

- – 玄学生成,因为需要连贯,你可能需要生成无数个视频,99%可能都是一坨屎,各种垮脸的关键帧,需要失败很多次,才有那么个能看的,所以按照这个原理,买在线平台比较不划算,因为每次生成都是计费的

如果要生成比较合理的长视频:

- – 合理的拆解分镜

- – 每个分镜要有适配模型的prompt,包括背景描述

- -玄学生成视频,力大出奇迹

这里笔者有点推荐使用【星火绘镜】来试着打造分镜,首图也可以保存, 后面生成视频的功能就别用了,瘆人。

几个可以同时支持图+文共同输入的模型:

- – 即梦

- – lumalabs.AI

- – Runway Gen-3 Alpha

1 产品调研

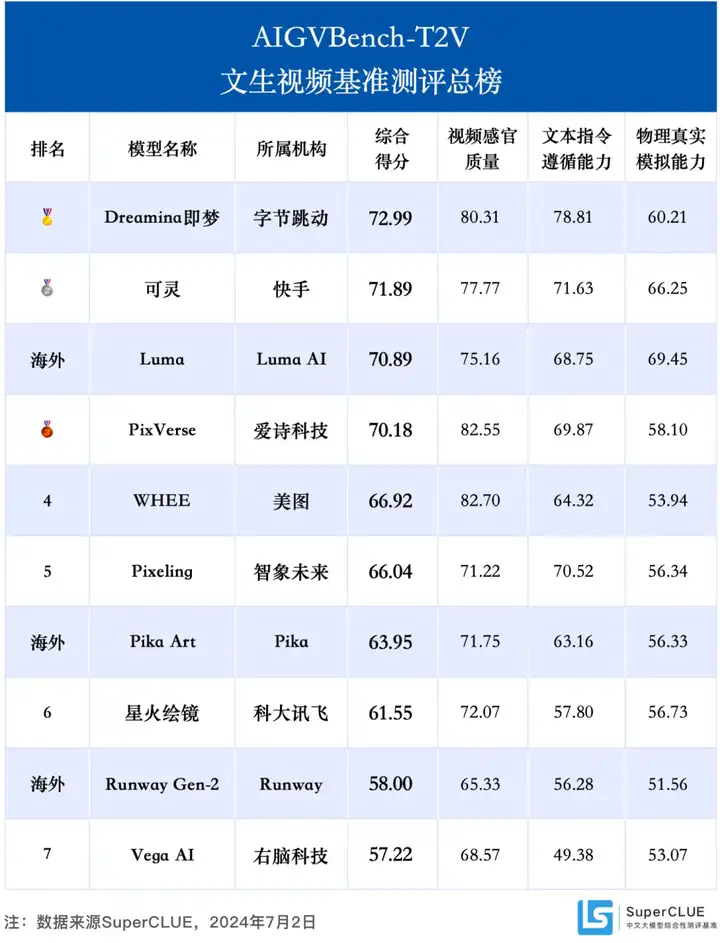

AIGC产品列表可见:视频生成AI视频生成

20240702更新一则公众号文章:

对文生视频的评价指标总榜:

1.1 快手:可灵(最牛)

申请到测试账户,生成短视频一般5s左右,示例视频的动作还蛮丰富

号称可以支持长视频:

非常牛逼,这是笔者看到最流畅的,具体可看:

1.2 lumalabs.AI

120 秒生成 120 帧,视频模型 Dream Machine

Dream Machine 可在 120 秒生成 120 帧,目前单个视频最长为 5 秒;生成的视频具有逼真的流畅运动、电影摄影和戏剧效果;还可以匹配摄像机运动,创造出“惊艳”的画面。 Luma AI 也提到了目前模型存在的问题,比如切换视角时汽车会变形,狗的运动没有用到爪子,显示文字会有问题(将 Luma 显示成 Lumma),北极熊在转身时出现了两个头(Janus 是罗马人的门神,具有前后两个面孔),官方表示他们仍将继续优化模型。

1.3 即梦 – 剪映旗下

有一些比较视觉的功能,比如运镜控制,还有首帧,尾帧的图片的上传可以固定首尾情况 但是整体5S中,可以连贯的剧情可能比较简单, 笔者体验下来可能仅仅实现的是图像动起来

生成的内容也会有变形,所以需要生成很多次才可以。

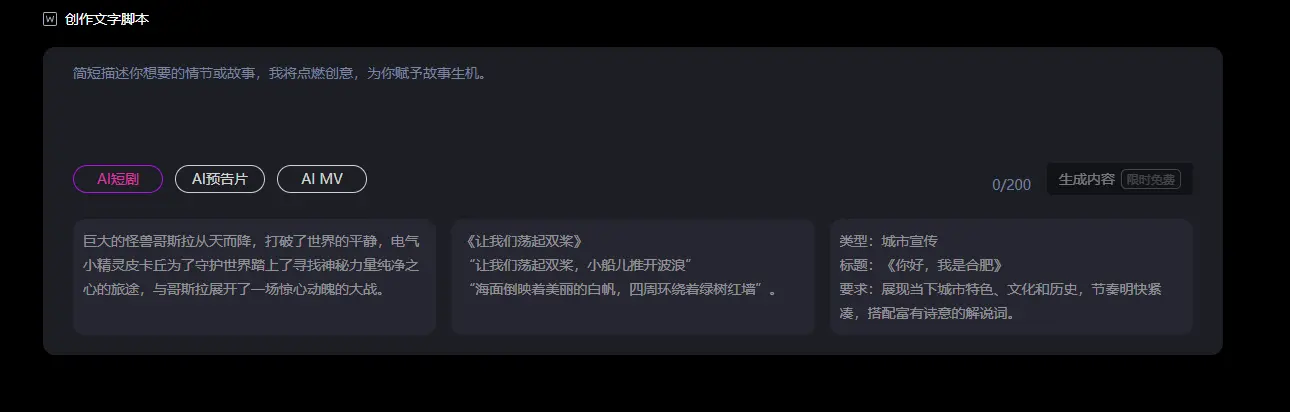

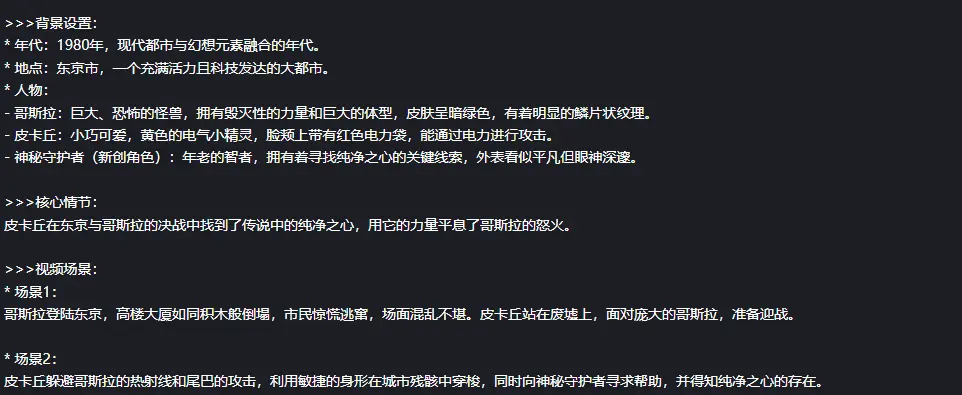

1.4 科大讯飞-星火绘镜

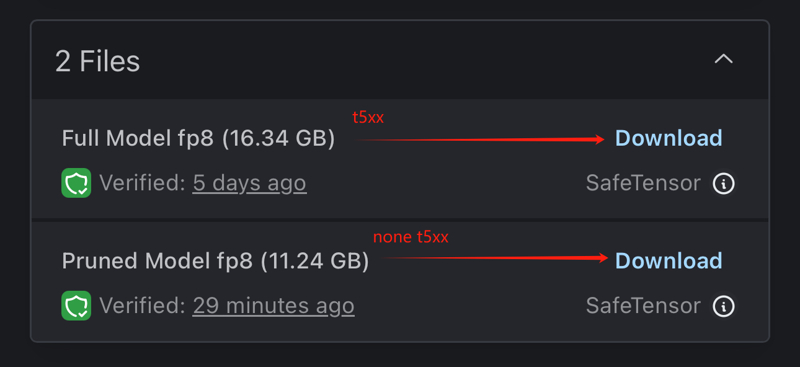

笔者猜测底层可能是【

】,使用的某个Lora都是高清现代人物,比较亮眼的长视频的分镜处理 第一步:给入主题大纲生成分幕剧情

第二步:根据每一个分镜描述,生成分镜首图,然后后续会根据这些首页图再次生成 咋说呢,首图看着确实很亮眼,但是后续生成的视频,简直不能看,胆小慎入… 反正不能人样…

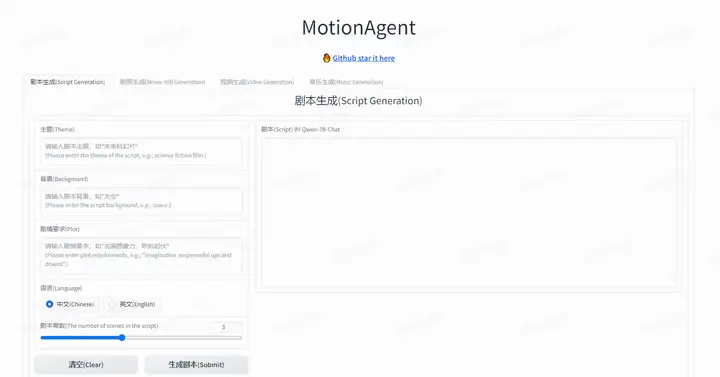

1.5 魔搭MotionAgent

MotionAgent是一个能将用户创造的剧本生成视频的深度学习模型工具。用户通过我们提供的工具组合,进行剧本创作、剧照生成、图片/视频生成、背景音乐谱写等工作。

是一个比较完整的项目了,包括剧本,音乐生成,就是缺了一个分镜就更好了 比较适合自己搭服务器玩

1.6 CogVideo

只有4s,可以免费试用的相对固定

1.7 runwayml

1.8 Stable Video

Stable Video是由著名的Stability AI推出的在线AI视频生成工具,目前拥有最强大的AI绘画模型之一,Stable Diffusion。它提供文本生成视频和图像生成视频两种模式,每天还可获得积分,免费生成多达十几个视频。

网址

测试下来,本质就是让图动起来,差了点意思,剧情感不强

1.9 Lumen5

Lumen5能够将长篇文章、博客等文本内容转化为视频,并提供丰富的视频模板供选择。用户可以对制作过程进行微调,添加素材等,享有高度自由度。 网址

1.10 腾讯智影 – 数字人创作

腾讯智影是一款集成了AI数字人物、AI文字转语音(TTS)、文章转视频等功能的智能创作工具。用户可以选择多种AI数字人物,并进行细节控制,如动作、服装等。 网址

1.11 即创 – 电商商品生成

即创是字节跳动专为抖音生态而推出的AI创作平台,能够通过AI快速生成文案、带货视频、直播以及商品宣传图等内容。同时也提供AI数字人功能。 用户可以通过抖音精选联盟的商品ID,在即创中一键生成爆款内容,非常适合从事抖音带货的用户。 官网

1.12 一帧秒创

拆分剧本,但是视频都是哪个影视剧的小片段裁剪的,不是合成的

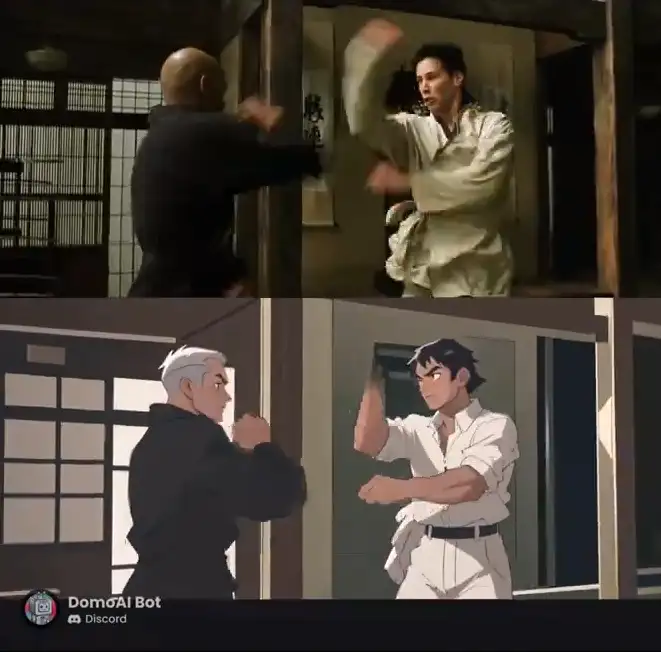

1.13 domoAI – 视频转动漫

官方 Discord 链接:

DomoAI 的服务目前托管 Discord 上的,可以将真人视频转化为动漫、3D、像素、彩色插画、中国水墨画等多种风格。下面是官方展示的真人视频转动漫视频的效果,非常稳定丝滑。

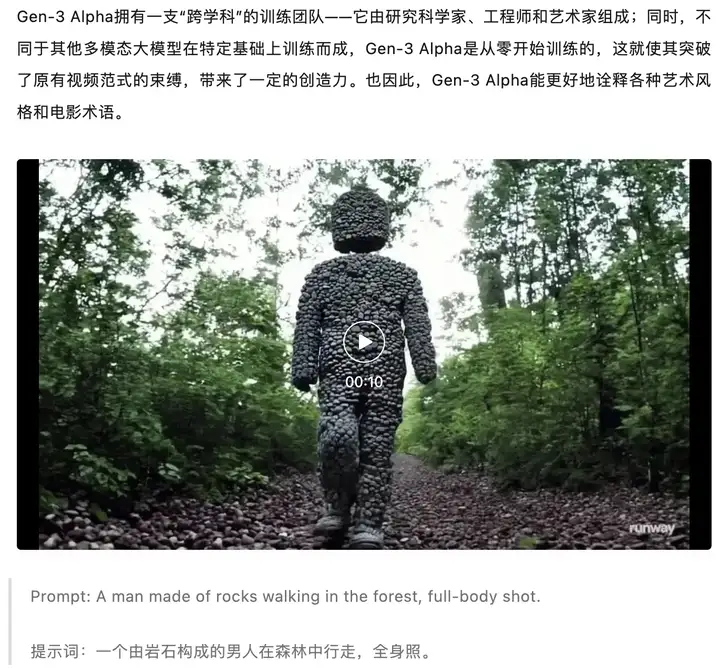

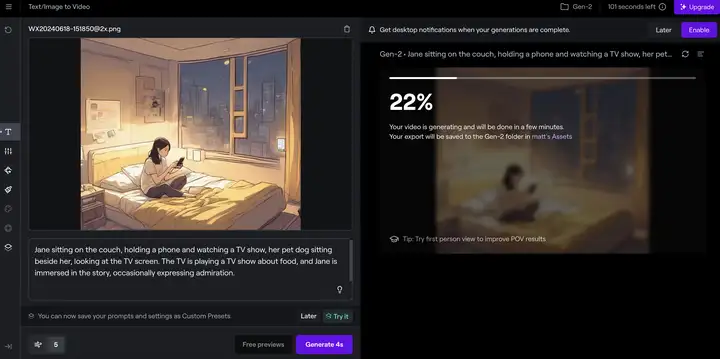

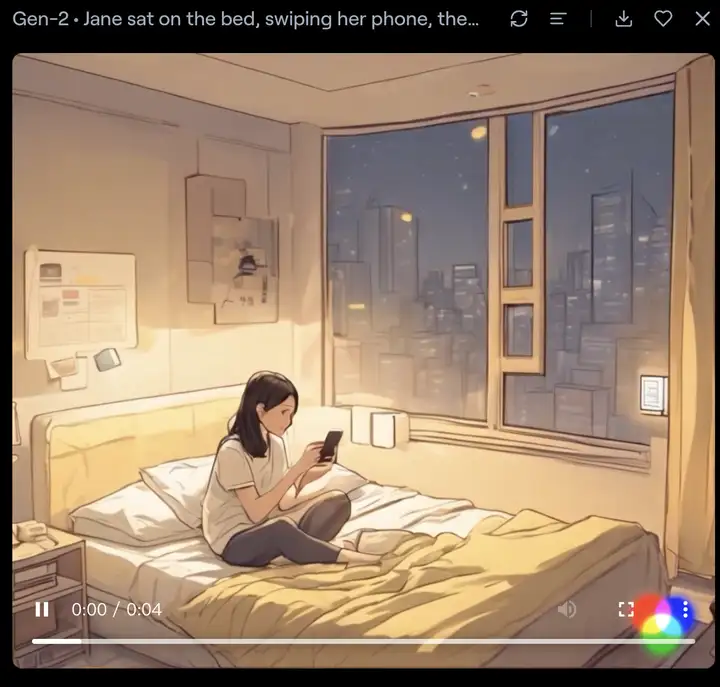

1.14 Runway Gen-3 Alpha

2024/6/18更新

整体有120s的免费时间 每次一般生成4s一段的视频

关联报道:

Gen-3 Alpha的五大功能特色 每一个功能都能让你的创意想法变为现实,发现Gen-3 Alpha能提供的优越体验。 – 文本到视频:将文本描述转换为视频。

- – 图像到视频:将静态图像转换为动态视频。

- – 文本到图像:将文本描述转换为静态图像。

- – 高级相机控制:精细控制视频拍摄角度和运动。

- – 导演模式:对视频的叙事和场景进行详细指导。

本次发布的Gen-3 Alpha模型使用视频和图像联合训练,其特色包括:

- – 90秒内快速生成10秒视频

- – 并行生成多个视频 – 模型驱动新的文本到视频(T2V)、图像到视频(I2V)和文本到图像(T2I)

- – 动作笔刷、高级摄像机控制、导演模式

- – 即将推出用于精细控制结构、风格、动作的工具

整个制作页面也蛮好:

当然笔者在测试的时候,一直想让人物有一个躺下的动作:

Jane sat on the bed, swiping her phone, then lay back on the bed, holding the phone as she lay down, keeping her eyes on the screen without shiftingJane sat on the bed, swiping her phone, then lay back on the bed, holding the phone as she lay down, keeping her eyes on the screen without shifting

Jane sat on the bed, swiping her phone, then lay back on the bed, holding the phone as she lay down, keeping her eyes on the screen without shifting

但是一直“躺不下”,可能这个动作时间不够。。

不过runway是可以直接使用extend功能, 当然,延长4s,依旧不能躺下。。

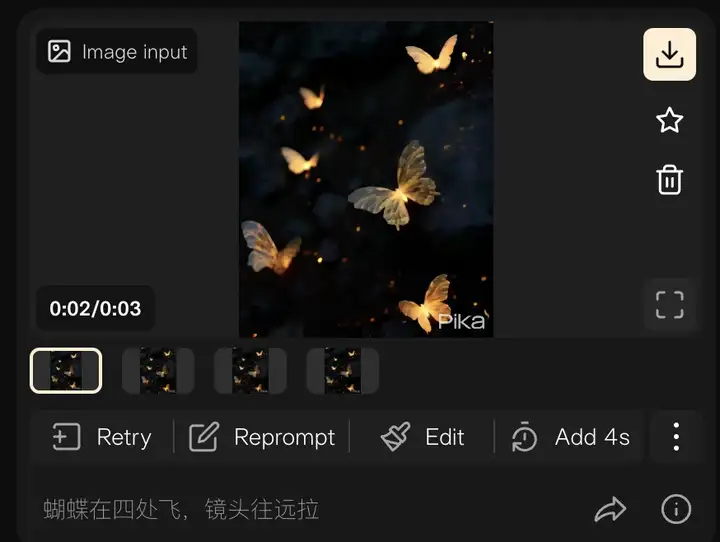

1.15 Pika Labs

Pika Labs 是一个强大的文本到视频平台,通过简单输入文字即可释放您的创造力。它提供丰富的功能,包括自动化视频生成、多种样式选择、音频配搭等,使您能够轻松创建个性化的视频内容。Pika Labs 定价灵活,并提供免费试用和付费套餐,满足不同用户的需求。无论您是个人创作者、营销人员还是企业用户,Pika Labs 都能帮助您快速制作出精美的视频作品。

一般是3s视频,还可以延长4s

整体效果还可以

1.16 Diffutoon:视频动漫化

Diffutoon 可以处理高分辨率、长时长的视频,还可以根据提示来编辑内容 在保持风格一致性和视觉质量上

样例视频:

1.17 达摩院发布一站式AI视频创作平台”寻光”

内测申请地址:https://xunguang.damo-vision.com/

对于每个分镜头,寻光提供完整且智能的 AI 视频编辑能力进行处理,可依据用户意图,在语义层面而不是像素层面实现编辑。分镜头里的人体、人脸、前景、背景等任意局部目标,都可以进行精细化的编辑和修改。

比如,理解空间景深的运镜控制;

又比如,能够理解物体相对关系的目标消除 / 修改。

在对视频全局元素的编辑上,寻光平台提供了超过 20 种的风格迁移。

寻光也提供帧率控制、视频超分等实用的视频编辑功能。

“我们希望一个视频里的所有元素都是可编辑、可修改的,这样可以给用户的创作提供最大的自由度”,陈威华说。

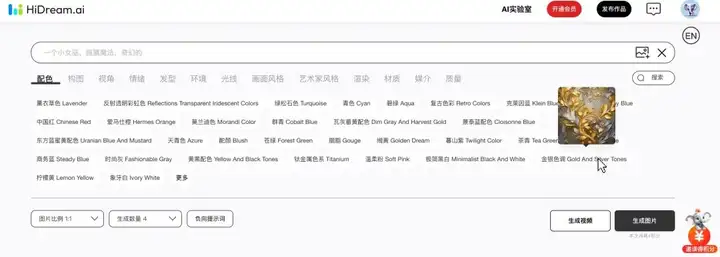

1.18 hidreamai

官网:

电商版本:

智象未来自研的「智象视觉大模型」已成为目前全球同时支持图像和视频生成的最大模型,模型参数已超过 130 亿,实现文本、图片、视频等多模态内容的生成。

目前主流的模型框架 Diffusion model 和 Auto-regressive model,恰好对应着前两种视频本质。Video Diffusion model 往往将视频看作一个时空的网格世界,并用 3D 卷积神经网络/Transformer 来进行编码;Auto-regressive model 则将视频理解为连续帧的序列,搭配 GPT 典型的自回归模型来进行编码。Diffusion model 基于扩散模型加噪去噪的机制可以更好地结构化并生成较高质量画质的视频内容,而 Auto-regressive model 更适合长上下文语境理解,天然适配多模态对话的生成方式。

AI 生成视频,一个典型的技术流程是:

利用 LLM 自动生成剧本来驱动视频,提升故事逻辑性,加入全局/局部运动的控制,实现精细的全局运镜和局部动作,最终结合图像/视频增强生成4K/8K的超高清视频。

从视频商业化路径来看,故事逻辑性、视觉可控性与画质高清是实现视频产品落地最后一公里的三大要素,也是电影这一视觉艺术在用户侧最直击内心的因素。

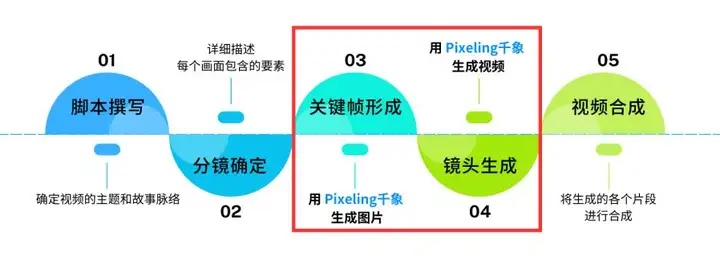

AI 生成图片和视频的工具——Pixeling 千象(http://www.hidreamai.com,千象万相),帮助用户一站式生成精准可控的图片、视频,经过视频增强后生成的 4k 超清画质,完美展现脑中灵感。

HidreamAI 的特点:

- HiDream.ai 有望突破视频普遍 4 秒的限制,生成 15 秒左右的视频

- 风格支持:水墨、梵高、宫崎骏、赛博朋克、动漫、卡通、水彩等 10 种风格

- 镜头控制的能力:用户可以实现上下、左右、前后六种单一方向以及组合方向的运镜

- “一横一纵”的发展战略:

- 一横:底层多模态大模型所推出的“Pixeling千象”应用,主要面向设计师人群提供服务

- 一纵:HiDream.ai会基于底层大模型的能力,针对不同的垂直行业提供产品和服务(面向电商商家的AI工具“PixMaker”,可以生成商品营销的商品图和人像模特图等)

参考:

HiDream CTO 姚霆:Sora 出圈,中国 AI 创业公司的机会在哪里? – 智源社区

自研多模态大模型投产,「HiDream.ai」获新一轮融资 | 36氪首发-36氪

1.19 堆友

相关文章:第一批正在被AIGC重置的行业有话说

AIGC文生图自然是基本功,在堆友里它叫“AI反应堆”,点进界面,包含prompt区、效果展示区、修改分发区。

功能包括很多:

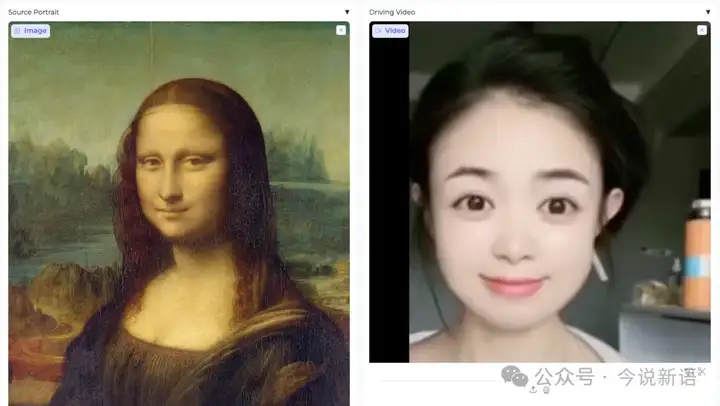

1.20 LivePortrait

体验路径:

文章材料:AI视频精细化控制能力升级:表情精准控制与多人口唇同步!

LivePortrait是快手和中科大、复旦合作开发推出的一项AI人像动画技术,可以将静态照片转换为动态肖像视频。与以往介绍的EMO类似《真惨!PIKA刚发布的这个功能被阿里秒杀了!》,该技术不仅能够实现面部表情和动作的生动再现,还能根据输入的视频驱动不同的表情和动作变化,提供更复杂生动的视频效果。

主要功能与特点

- 动态肖像生成:通过输入静态照片和驱动视频,LivePortrait能够生成逼真的动态肖像视频。驱动视频决定了肖像的动作和表情变化,从而使静态照片“动”起来。

- 面部特征预测:即使输入的照片仅为正面照且缺少部分面部细节(如耳朵、牙齿等),算法也能够预测并生成这些缺失的部分,从而提升肖像的完整性和真实感 。

- 高灵活性:LivePortrait支持多种驱动视频,用户可以选择预设的动画动作,也可以自行创建独特的驱动视频,以满足不同场景的需求 。

- 面部裁剪与排序:支持对多张面孔进行处理,可以指定特定的面孔进行优先处理,并通过设置参数来调整面孔排序方向和裁剪区域。

LivePortrait的使用过程相对简单:

- 用户需要上传一张静态照片和一段具有表情变化的参考视频。

- 系统会同步视频中人物的表情,让静态照片动起来,并实现真实细腻的表情变化。

- 此外还可以编辑源肖像的眼睛和嘴唇张开比例,通过拖动滑块并单击重新定位按钮,可以生成改变后的图像。

- 该技术已经在ComfyUI中实现,用户可以在本地部署或使用云端镜像体验

2 文生图的Prompt

笔者在测试prompt的时候,需要遵循尽量简单的词汇

来简单看看一些sora / 可灵官方的prompt:

一个玩具机器人穿着绿色连衣裙和遮阳帽,在南极洲美丽的日落时分愉快地散步视频中展示人们在海滩放松,然后在一半时有一只鲨鱼跳出水面吓了所有人一只柯基在夏威夷的热带岛屿Maui自拍视频。一部电影预告,展示一位 30 岁的太空人冒险经历,他戴着红色羊毛针织的摩托车头盔,背景是蓝天和盐漠,电影风格,采用 35 mm胶片拍摄,色彩鲜艳。一个男人骑着马在戈壁沙漠飞奔,背后美丽的夕阳,电影级别画面小男孩在花园里骑自行车经历秋冬春夏四季变换一名宇航员在月球表面奔跑,低角度镜头展现了月球的广阔背景,动作流畅且显得轻盈一辆拉力赛车在赛道上快速转弯小心地将牛奶倒入杯中,奶流平稳,杯子渐渐被奶白色填满一只白猫在车里驾驶,穿过繁忙的市区街道,背景是高楼和行人微距镜头,火山在一个咖啡杯中喷发露水在蓝色玫瑰花瓣上,高清,近景,细节一对男女手牵手在星空下行走,背景斗转星移一个玩具机器人穿着绿色连衣裙和遮阳帽,在南极洲美丽的日落时分愉快地散步

视频中展示人们在海滩放松,然后在一半时有一只鲨鱼跳出水面吓了所有人

一只柯基在夏威夷的热带岛屿Maui自拍视频。

一部电影预告,展示一位 30 岁的太空人冒险经历,他戴着红色羊毛针织的摩托车头盔,背景是蓝天和盐漠,电影风格,采用 35 mm胶片拍摄,色彩鲜艳。

一个男人骑着马在戈壁沙漠飞奔,背后美丽的夕阳,电影级别画面

小男孩在花园里骑自行车经历秋冬春夏四季变换

一名宇航员在月球表面奔跑,低角度镜头展现了月球的广阔背景,动作流畅且显得轻盈

一辆拉力赛车在赛道上快速转弯

小心地将牛奶倒入杯中,奶流平稳,杯子渐渐被奶白色填满

一只白猫在车里驾驶,穿过繁忙的市区街道,背景是高楼和行人

微距镜头,火山在一个咖啡杯中喷发

露水在蓝色玫瑰花瓣上,高清,近景,细节

一对男女手牵手在星空下行走,背景斗转星移

一个玩具机器人穿着绿色连衣裙和遮阳帽,在南极洲美丽的日落时分愉快地散步

视频中展示人们在海滩放松,然后在一半时有一只鲨鱼跳出水面吓了所有人

一只柯基在夏威夷的热带岛屿Maui自拍视频。

一部电影预告,展示一位 30 岁的太空人冒险经历,他戴着红色羊毛针织的摩托车头盔,背景是蓝天和盐漠,电影风格,采用 35 mm胶片拍摄,色彩鲜艳。

一个男人骑着马在戈壁沙漠飞奔,背后美丽的夕阳,电影级别画面

小男孩在花园里骑自行车经历秋冬春夏四季变换

一名宇航员在月球表面奔跑,低角度镜头展现了月球的广阔背景,动作流畅且显得轻盈

一辆拉力赛车在赛道上快速转弯

小心地将牛奶倒入杯中,奶流平稳,杯子渐渐被奶白色填满

一只白猫在车里驾驶,穿过繁忙的市区街道,背景是高楼和行人

微距镜头,火山在一个咖啡杯中喷发

露水在蓝色玫瑰花瓣上,高清,近景,细节

一对男女手牵手在星空下行走,背景斗转星移

所以在一些简单的描述性词汇外,还可以留意prompt可以加入以下几种类型的词汇,来丰富场景词:

- 背景/场景词:比如背景斗转星移,背景是高楼和行人

- 视频风格类型:纪实风格,叙事风格,戏剧风格,实验风格,音乐视频风格,广告风格,新闻风格,动画风格,纪录片风格,电影风格,电视风格

- 视频镜头类型:远景,全景,中景,近景,特写,平视角,俯视角,仰视角,鸟瞰角,倾斜角,短镜头,长镜头

- 视频运镜类型:推近镜头拉远镜头,摇镜头,俯仰镜头,移镜头,升降镜头,变焦镜头,手持镜头,航拍镜头

笔者一般会使用下面的prompt让GPT 先给一些提示:

有一个文本生视频任务需要写一段prompt根据上述主题,并参考 <prompt示例> 写一个专业的prompt<主题>【女孩抬起手触碰到帽檐】<要求>- prompt输出字数范围在20-200字- 结合<主题>内容,合理得在prompt加入背景、<视频风格类型> 、 <视频镜头类型> 、 <视频运镜类型>等信息,并不是每一个prompt都需要上述信息- 同时给出3-5组prompt,供选择<视频风格类型>```纪实风格叙事风格戏剧风格实验风格音乐视频风格广告风格新闻风格动画风格纪录片风格电影风格电视风格```<视频镜头类型>```远景全景中景近景特写平视角俯视角仰视角鸟瞰角倾斜角短镜头长镜头```<视频运镜类型>```推近镜头拉远镜头摇镜头俯仰镜头移镜头升降镜头变焦镜头手持镜头航拍镜头```<prompt示例>```一个玩具机器人穿着绿色连衣裙和遮阳帽,在南极洲美丽的日落时分愉快地散步视频中展示人们在海滩放松,然后在一半时有一只鲨鱼跳出水面吓了所有人一只柯基在夏威夷的热带岛屿Maui自拍视频。一部电影预告,展示一位 30 岁的太空人冒险经历,他戴着红色羊毛针织的摩托车头盔,背景是蓝天和盐漠,电影风格,采用 35 mm胶片拍摄,色彩鲜艳。一个男人骑着马在戈壁沙漠飞奔,背后美丽的夕阳,电影级别画面小男孩在花园里骑自行车经历秋冬春夏四季变换一名宇航员在月球表面奔跑,低角度镜头展现了月球的广阔背景,动作流畅且显得轻盈一辆拉力赛车在赛道上快速转弯小心地将牛奶倒入杯中,奶流平稳,杯子渐渐被奶白色填满一只白猫在车里驾驶,穿过繁忙的市区街道,背景是高楼和行人微距镜头,火山在一个咖啡杯中喷发露水在蓝色玫瑰花瓣上,高清,近景,细节一对男女手牵手在星空下行走,背景斗转星移```有一个文本生视频任务需要写一段prompt

根据上述主题,并参考 <prompt示例> 写一个专业的prompt

<主题>

【女孩抬起手触碰到帽檐】

<要求>

- prompt输出字数范围在20-200字

- 结合<主题>内容,合理得在prompt加入背景、<视频风格类型> 、 <视频镜头类型> 、 <视频运镜类型>等信息,并不是每一个prompt都需要上述信息

- 同时给出3-5组prompt,供选择

<视频风格类型>

```

纪实风格

叙事风格

戏剧风格

实验风格

音乐视频风格

广告风格

新闻风格

动画风格

纪录片风格

电影风格

电视风格

```

<视频镜头类型>

```

远景

全景

中景

近景

特写

平视角

俯视角

仰视角

鸟瞰角

倾斜角

短镜头

长镜头

```

<视频运镜类型>

```

推近镜头

拉远镜头

摇镜头

俯仰镜头

移镜头

升降镜头

变焦镜头

手持镜头

航拍镜头

```

<prompt示例>

```

一个玩具机器人穿着绿色连衣裙和遮阳帽,在南极洲美丽的日落时分愉快地散步

视频中展示人们在海滩放松,然后在一半时有一只鲨鱼跳出水面吓了所有人

一只柯基在夏威夷的热带岛屿Maui自拍视频。

一部电影预告,展示一位 30 岁的太空人冒险经历,他戴着红色羊毛针织的摩托车头盔,背景是蓝天和盐漠,电影风格,采用 35 mm胶片拍摄,色彩鲜艳。

一个男人骑着马在戈壁沙漠飞奔,背后美丽的夕阳,电影级别画面

小男孩在花园里骑自行车经历秋冬春夏四季变换

一名宇航员在月球表面奔跑,低角度镜头展现了月球的广阔背景,动作流畅且显得轻盈

一辆拉力赛车在赛道上快速转弯

小心地将牛奶倒入杯中,奶流平稳,杯子渐渐被奶白色填满

一只白猫在车里驾驶,穿过繁忙的市区街道,背景是高楼和行人

微距镜头,火山在一个咖啡杯中喷发

露水在蓝色玫瑰花瓣上,高清,近景,细节

一对男女手牵手在星空下行走,背景斗转星移

```

有一个文本生视频任务需要写一段prompt

根据上述主题,并参考 <prompt示例> 写一个专业的prompt

<主题>

【女孩抬起手触碰到帽檐】

<要求>

- prompt输出字数范围在20-200字

- 结合<主题>内容,合理得在prompt加入背景、<视频风格类型> 、 <视频镜头类型> 、 <视频运镜类型>等信息,并不是每一个prompt都需要上述信息

- 同时给出3-5组prompt,供选择

<视频风格类型>

```

纪实风格

叙事风格

戏剧风格

实验风格

音乐视频风格

广告风格

新闻风格

动画风格

纪录片风格

电影风格

电视风格

```

<视频镜头类型>

```

远景

全景

中景

近景

特写

平视角

俯视角

仰视角

鸟瞰角

倾斜角

短镜头

长镜头

```

<视频运镜类型>

```

推近镜头

拉远镜头

摇镜头

俯仰镜头

移镜头

升降镜头

变焦镜头

手持镜头

航拍镜头

```

<prompt示例>

```

一个玩具机器人穿着绿色连衣裙和遮阳帽,在南极洲美丽的日落时分愉快地散步

视频中展示人们在海滩放松,然后在一半时有一只鲨鱼跳出水面吓了所有人

一只柯基在夏威夷的热带岛屿Maui自拍视频。

一部电影预告,展示一位 30 岁的太空人冒险经历,他戴着红色羊毛针织的摩托车头盔,背景是蓝天和盐漠,电影风格,采用 35 mm胶片拍摄,色彩鲜艳。

一个男人骑着马在戈壁沙漠飞奔,背后美丽的夕阳,电影级别画面

小男孩在花园里骑自行车经历秋冬春夏四季变换

一名宇航员在月球表面奔跑,低角度镜头展现了月球的广阔背景,动作流畅且显得轻盈

一辆拉力赛车在赛道上快速转弯

小心地将牛奶倒入杯中,奶流平稳,杯子渐渐被奶白色填满

一只白猫在车里驾驶,穿过繁忙的市区街道,背景是高楼和行人

微距镜头,火山在一个咖啡杯中喷发

露水在蓝色玫瑰花瓣上,高清,近景,细节

一对男女手牵手在星空下行走,背景斗转星移

```

这里有一则可灵大模型提示词(Prompt)构成:

镜头语言:通过镜头应用和切换传达故事或信息,创造视觉效果和情感氛围。光影:光影的运用增加照片深度和情感表达。主体:视频中的主要表现对象,如人、动物、植物或物体。主体描述:对主体外貌和姿态的描述。主体运动:描述主体的运动状态,需符合5秒视频展现。场景描述:对主体所处环境的描述,需符合5秒视频展现。氛围:描述预期视频画面的氛围,如热闹、电影级调色、温馨等。镜头语言:通过镜头应用和切换传达故事或信息,创造视觉效果和情感氛围。

光影:光影的运用增加照片深度和情感表达。

主体:视频中的主要表现对象,如人、动物、植物或物体。

主体描述:对主体外貌和姿态的描述。

主体运动:描述主体的运动状态,需符合5秒视频展现。

场景描述:对主体所处环境的描述,需符合5秒视频展现。

氛围:描述预期视频画面的氛围,如热闹、电影级调色、温馨等。

镜头语言:通过镜头应用和切换传达故事或信息,创造视觉效果和情感氛围。

光影:光影的运用增加照片深度和情感表达。

主体:视频中的主要表现对象,如人、动物、植物或物体。

主体描述:对主体外貌和姿态的描述。

主体运动:描述主体的运动状态,需符合5秒视频展现。

场景描述:对主体所处环境的描述,需符合5秒视频展现。

氛围:描述预期视频画面的氛围,如热闹、电影级调色、温馨等。

同时有一个coze封装的写prompt的agent:

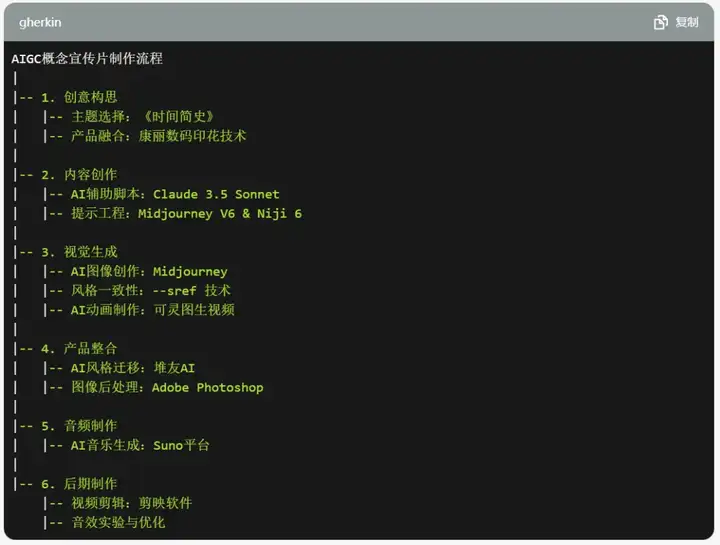

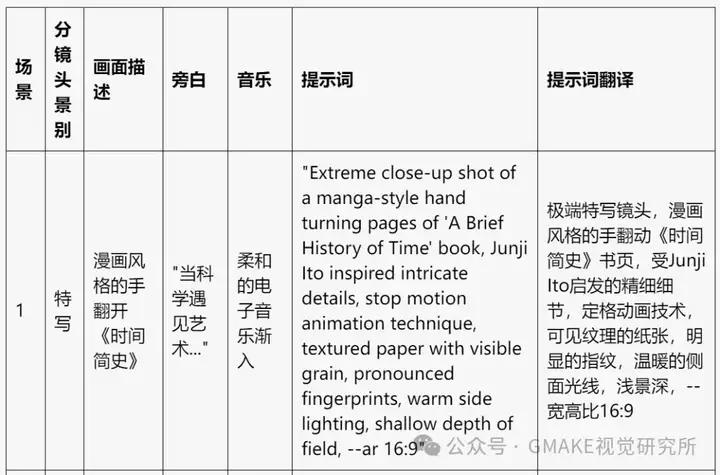

3 一个很帅的AIGC短视频制作全流程

感谢GMAKE视觉研究所,让我感受到一个AIGC完整的短视频制作流程:

以思维导图的形式概述整个制作流程:

具体可以看原文,这里列几个笔者觉得很赞的思路点

思路一:需要非常完整的分镜脚本

思路二:好的视频后期制作与最终整合必不可少

在这个最后的阶段,我们的目标是将所有元素整合在一起,创造出一个连贯、引人入胜的30秒概念宣传片。这个过程涉及视频剪辑、特效添加、音频同步等多个方面。

视频剪辑我们选择使用剪映软件进行视频剪辑,这是一个直观且功能强大的工具,特别适合短视频制作。a) 镜头排序:根据我们的分镜头脚本,将AI生成的动画片段按顺序排列。b) 转场效果:在不同场景之间添加适当的转场效果,如溶解、推移等,以增强视觉流畅性。c) 节奏调整:通过调整每个片段的持续时间,确保整个视频的节奏与背景音乐相匹配。d) 色彩校正:使用剪映的色彩调整工具,确保所有场景的色调一致,增强整体视觉连贯性。关键AIGC概念:智能剪辑辅助(Intelligent Editing Assistance):利用AI算法辅助视频剪辑,如自动检测最佳切点、智能调色等。特效添加虽然AI生成的动画已经相当精彩,但我们还是添加了一些额外的特效来增强某些关键概念的视觉表现。a) 特效处理:在一些关键镜头中添加镜头运动效果,强化科幻感。b) 文字动画:为一些关键科学概念添加简短的文字说明,使用动态文字效果使其自然地融入画面。音频同步与混合这一步骤对于创造沉浸式体验至关重要。a) 音乐同步:将AI生成的背景音乐导入剪映,并与视频画面同步。调整音乐的起始点,确保关键视觉元素与音乐高潮点相匹配。b) 音量调节:微调背景音乐的音量曲线,在关键视觉时刻略微提高音量,增强戏剧性效果。c) 音频过渡:在音乐的开始和结束处添加淡入淡出效果,使整个音频体验更加圆润。视频剪辑

我们选择使用剪映软件进行视频剪辑,这是一个直观且功能强大的工具,特别适合短视频制作。

a) 镜头排序:根据我们的分镜头脚本,将AI生成的动画片段按顺序排列。

b) 转场效果:在不同场景之间添加适当的转场效果,如溶解、推移等,以增强视觉流畅性。

c) 节奏调整:通过调整每个片段的持续时间,确保整个视频的节奏与背景音乐相匹配。

d) 色彩校正:使用剪映的色彩调整工具,确保所有场景的色调一致,增强整体视觉连贯性。

关键AIGC概念:

智能剪辑辅助(Intelligent Editing Assistance):利用AI算法辅助视频剪辑,如自动检测最佳切点、智能调色等。

特效添加

虽然AI生成的动画已经相当精彩,但我们还是添加了一些额外的特效来增强某些关键概念的视觉表现。

a) 特效处理:在一些关键镜头中添加镜头运动效果,强化科幻感。

b) 文字动画:为一些关键科学概念添加简短的文字说明,使用动态文字效果使其自然地融入画面。

音频同步与混合

这一步骤对于创造沉浸式体验至关重要。

a) 音乐同步:将AI生成的背景音乐导入剪映,并与视频画面同步。调整音乐的起始点,确保关键视觉元素与音乐高潮点相匹配。

b) 音量调节:微调背景音乐的音量曲线,在关键视觉时刻略微提高音量,增强戏剧性效果。

c) 音频过渡:在音乐的开始和结束处添加淡入淡出效果,使整个音频体验更加圆润。

视频剪辑

我们选择使用剪映软件进行视频剪辑,这是一个直观且功能强大的工具,特别适合短视频制作。

a) 镜头排序:根据我们的分镜头脚本,将AI生成的动画片段按顺序排列。

b) 转场效果:在不同场景之间添加适当的转场效果,如溶解、推移等,以增强视觉流畅性。

c) 节奏调整:通过调整每个片段的持续时间,确保整个视频的节奏与背景音乐相匹配。

d) 色彩校正:使用剪映的色彩调整工具,确保所有场景的色调一致,增强整体视觉连贯性。

关键AIGC概念:

智能剪辑辅助(Intelligent Editing Assistance):利用AI算法辅助视频剪辑,如自动检测最佳切点、智能调色等。

特效添加

虽然AI生成的动画已经相当精彩,但我们还是添加了一些额外的特效来增强某些关键概念的视觉表现。

a) 特效处理:在一些关键镜头中添加镜头运动效果,强化科幻感。

b) 文字动画:为一些关键科学概念添加简短的文字说明,使用动态文字效果使其自然地融入画面。

音频同步与混合

这一步骤对于创造沉浸式体验至关重要。

a) 音乐同步:将AI生成的背景音乐导入剪映,并与视频画面同步。调整音乐的起始点,确保关键视觉元素与音乐高潮点相匹配。

b) 音量调节:微调背景音乐的音量曲线,在关键视觉时刻略微提高音量,增强戏剧性效果。

c) 音频过渡:在音乐的开始和结束处添加淡入淡出效果,使整个音频体验更加圆润。

龙跃AI 助手

龙跃AI 助手

暂无评论内容