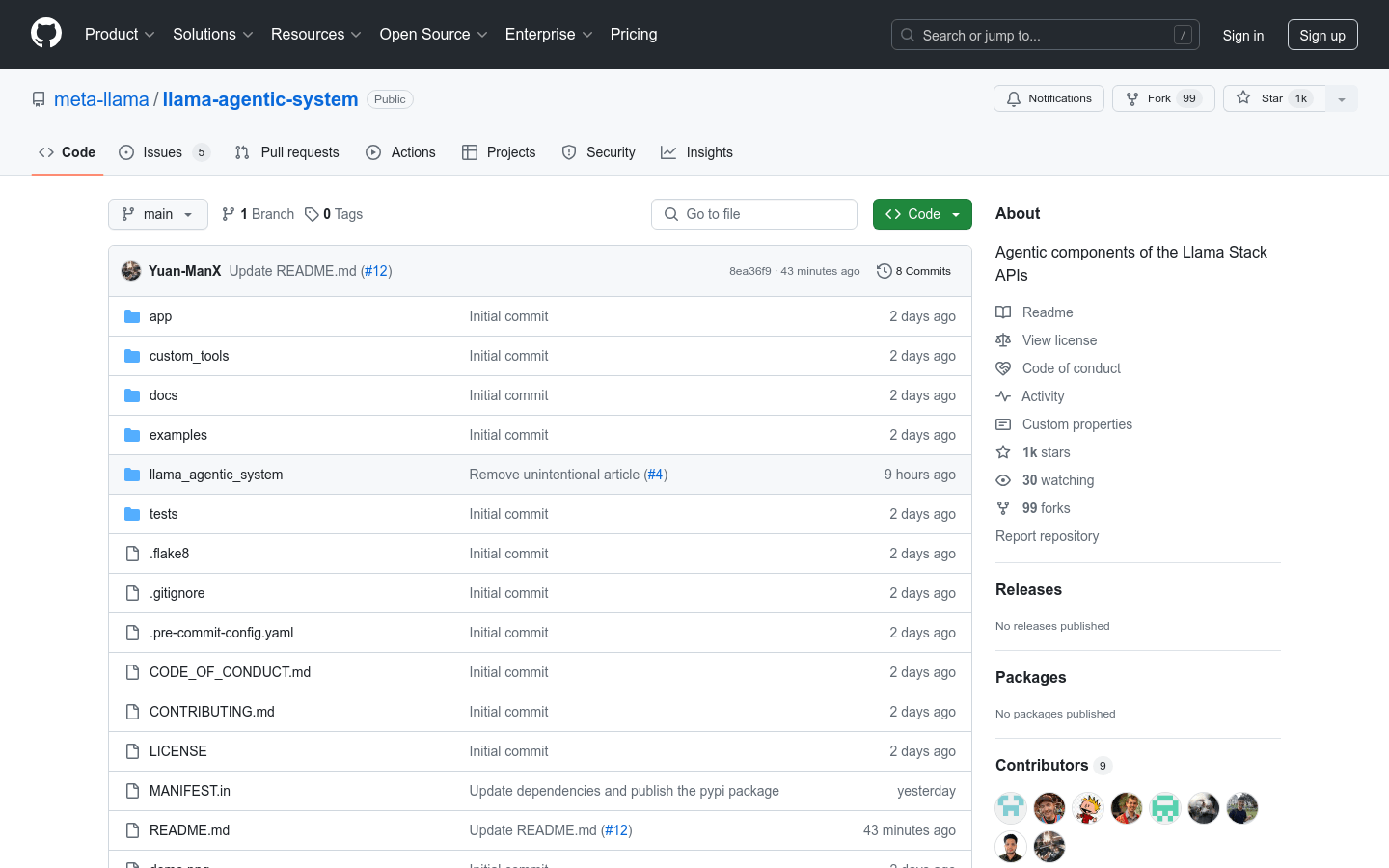

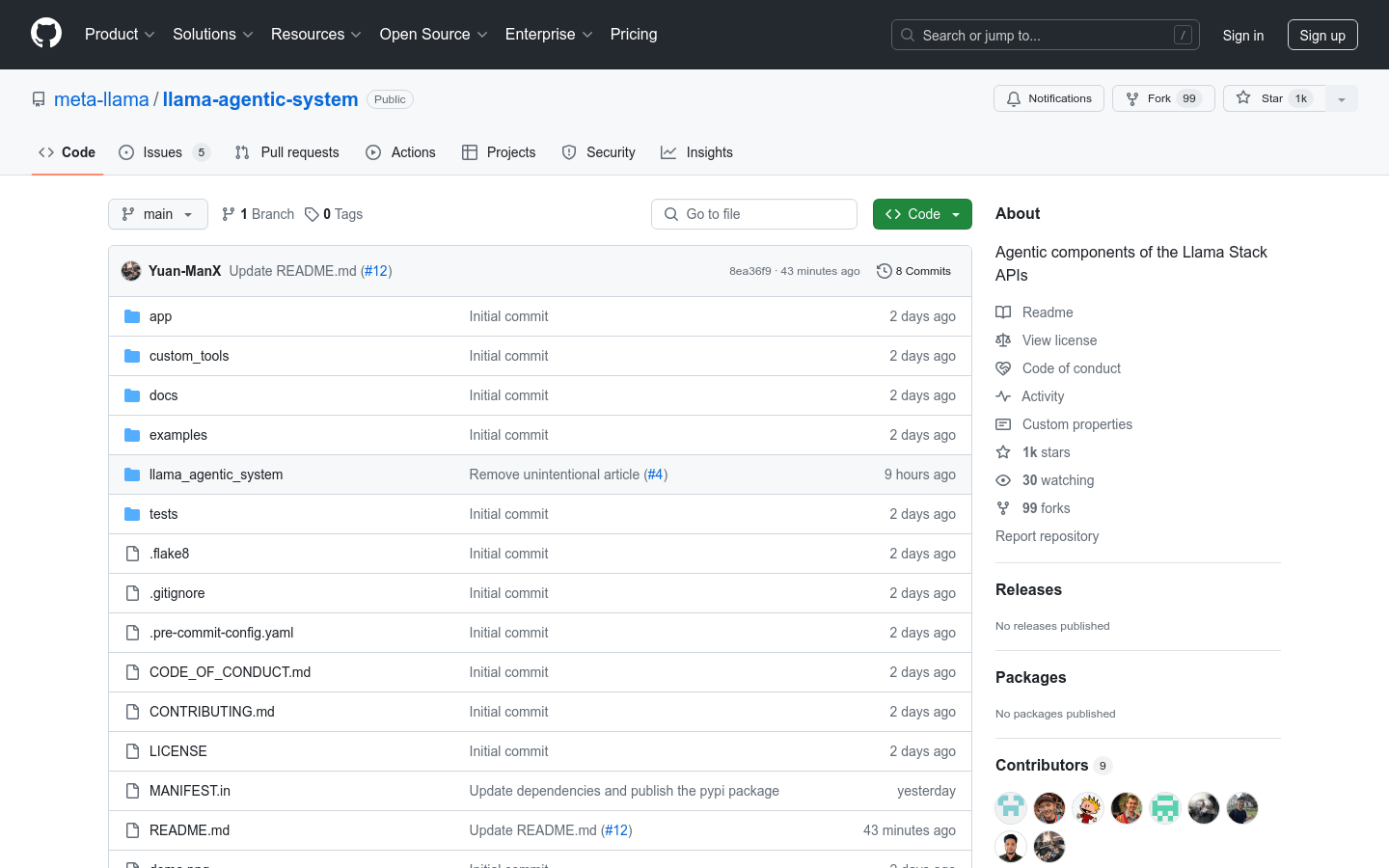

llama-agentic-system

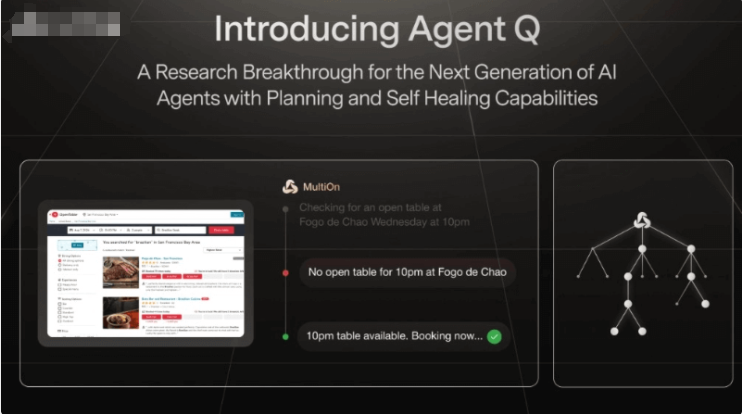

Llama-agentic-system是一个基于Llama 3.1模型的系统级代理组件,它能够执行多步骤推理和使用内置工具,如搜索引擎或代码解释器。该系统还强调了安全性评估,通过Llama Guard进行输入和输出过滤,以确保在不同使用场景下的安全需求得到满足。

需求人群:

“目标受众为开发者和研究人员,他们需要利用先进的语言模型来构建能够执行复杂任务的系统。该产品适合那些希望在保持模型灵活性和适应性的同时,确保系统安全性的用户。”

使用场景示例:

使用Llama-agentic-system构建一个能够自动规划旅行的聊天机器人。

集成到现有的开发流程中,以自动化代码审查和问题解答。

作为教育工具,帮助学生理解复杂的概念和问题解决策略。

产品特色:

支持多步骤推理和任务分解

内置和零样本学习调用工具的能力

系统级安全评估,使用Llama Guard进行输入输出过滤

支持自定义虚拟环境和依赖安装

支持实时fp8量化以提高性能

提供命令行界面(CLI)帮助用户下载模型、配置推理服务器和运行代理系统应用

提供示例脚本和UI界面,方便用户快速开始

使用教程:

1. 创建并激活Conda环境,安装所需的Python版本。

2. 安装Llama-agentic-system包及其依赖。

3. 如果需要,安装并配置实时fp8量化所需的fbgemm-gpu包。

4. 下载所需的Llama 3.1模型检查点。

5. 配置推理服务器,填写检查点、模型并行大小等信息。

6. 启动推理服务器,使其在本地运行。

7. 配置代理系统,包括模型检查点目录和安全配置。

8. 启动代理应用,并通过UI或脚本与服务器进行交互。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

喜欢就支持一下吧

相关推荐