要在本地部署DeepSeek模型,以下是详细步骤:

1.环境准备

硬件要求:最低配置为CPU(支持AVX2指令集)+ 16GB内存 + 30GB存储。推荐配置为NVIDIA GPU(RTX 3090或更高)+ 32GB内存 + 50GB存储。

软件依赖:操作系统可以选择Windows、macOS或Linux。如果使用Open Web UI,需要安装Docker。

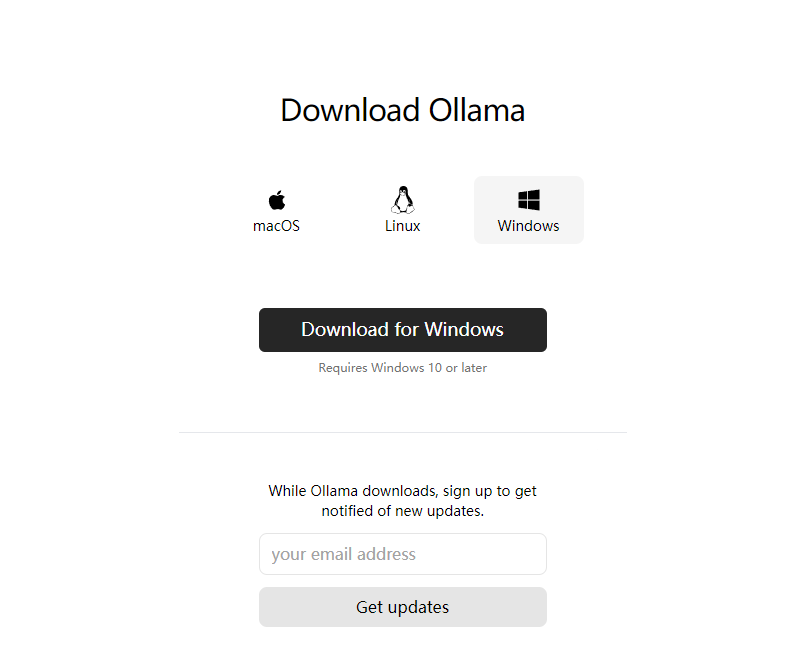

2.安装Ollama

访问Ollama官网:https://ollama.com/,点击“Download”按钮。

根据操作系统选择对应的安装包,下载并安装。

安装完成后,在终端输入ollama –version检查版本号,确认安装成功。

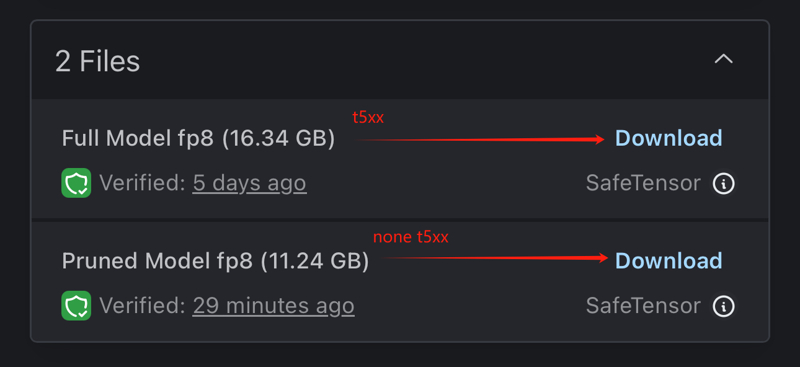

3.下载并部署DeepSeek模型

打开Ollama官网,进入“Models”页面,选择“deepseek-r1”模型。

根据硬件配置选择合适的模型版本,例如:

1.5B版本:适合初步测试。

7B或8B版本:适合大多数消费级GPU。

14B、32B或70B版本:适合高端GPU。

在终端中,使用以下命令下载并运行模型:

ollama run deepseek-r1:7b # 下载并运行7B版本

等待下载和安装完成,显示“success”表示模型已就绪。

4.使用Open Web UI(可选)

确保已安装Docker。

在终端中运行以下命令启动Open Web UI:

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui ghcr.io/open-webui/open-webui:main

访问http://localhost:3000,选择deepseek-r1:latest模型即可开始使用。

5.性能优化与资源管理

根据硬件配置选择合适的模型版本,避免资源不足。

确保系统有足够的内存和存储空间。

6.常见问题及解决方法

模型下载超时:尝试重新运行下载命令。

服务启动失败:确保Ollama服务已正确安装并启动,检查环境变量设置。

通过以上步骤,你可以在本地成功部署DeepSeek模型,并通过命令行或Web UI与模型进行交互。

龙跃AI 助手

龙跃AI 助手

暂无评论内容